搜索引擎优化(SEO)是所有关于使网站更好地理解的搜索引擎,而不是仅仅希望他们会自己弄清楚这一切。 它既是一门艺术,也是一门科学,还有很多技术SEO方面为您的网站排名提供了重要组成部分。

虽然许多算法更新和政策仍然模糊不清,但Google确实为google Search Console中大型网站的未来搜索引擎可见性提供了一些性能指标见解。

继续阅读以发现我的前五名SEO绩效指标-以及如何阅读它们的信号:

- 1. 页面下载速度

- 2. 每天抓取的页面

- 3. 站点地图页面与索引页面

- 4. 已爬网页与索引页

- 5. 结构化数据

1. 页面下载速度

以用户体验为重点的互联网公司痴迷于速度,谷歌就是其中之一。 许多关于HTML延迟影响的研究,例如这项研究,已经证明延迟会杀死用户的转换,即使是长期的。 随着更快的设备和互联网连接变得广泛可用,用户对延迟的容忍度在此后的几年中有所下降。

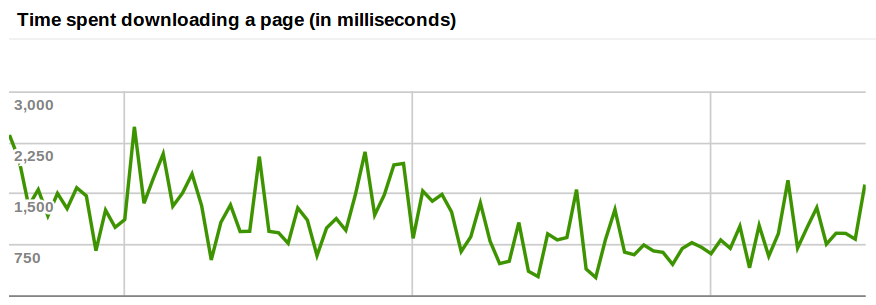

这就是为什么页面下载速度非常重要的原因。谷歌搜索控制台(Gsc,以前是Google网站管理员工具)表示Googlebot抓取页面所需的平均时间。 目标必须是保持该值尽可能低,最好始终低于500毫秒。

增加如下图所示的值会令人震惊地超过基准参数,并且随着时间的推移可能会减少每天爬网的页面数量。

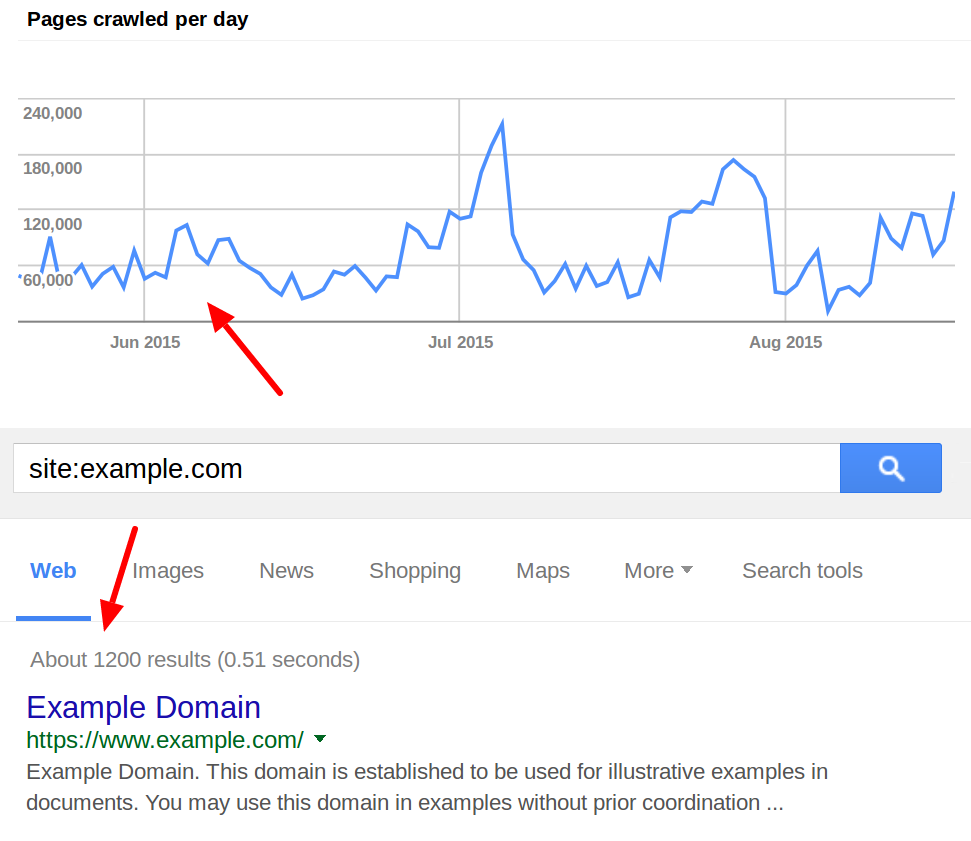

2. 每天抓取的页面

网站越快,它就越有可能为Googlebot处理更多连接。 如果平均页面下载速度上升,Google试图自动找出抓取有问题网站的安全边际,那么Googlebot在一天内抓取的平均页面量往往会下降。

这两个值是一个强烈的信号,表明一个网站没有充分发挥其潜力,无论是在谷歌的自然搜索,也不是它的用户。 这两个指标合并在一起,花费下载的时间不断增长,每天抓取的页面越来越少,几乎总是表明随着时间的推移可能影响自然搜索可见性的网站性能问题。 基础设施和体系结构必须加以审查,并且必须加以改进,以便恢复这些趋势。

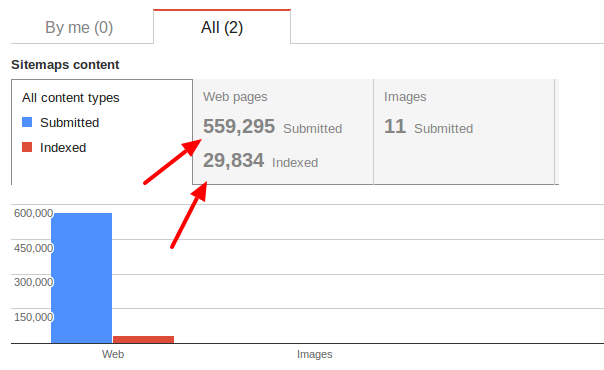

3. 站点地图页面与索引页面

索引页数与XML站点地图提交给GSC可以表明严重的SEO问题。 这些范围可以从有太多的孤立页面,一个破碎的内部链接结构,重复的内容,或缓慢的页面速度,仅举几例。 Google可能无法抓取和/或索引XML站点地图中列出的所有Url的原因有很多。 为了从GSC Sitemaps功能中获得最有用的数据,必须在XML sitemaps中提交网站的所有唯一规范,并在可能的情况下将XML Sitemap按URL类型划分为多个文件,以便将每个文件独立提交给GSC,这样就可以更好地识别网站上的差异。

4. 已爬网页与索引页

网站性能的另一个重要指标是每天抓取的页面与google中索引的页面的比率。 价值是一个重要问题的答案:Google需要抓取多少页面才能索引并排名一个? 经验表明,对于大型商业网站来说,10/1的比率是一个合理的值。 不幸的是,十到一百倍的不利比率并非闻所未闻。

如果确定,这些趋势可能表明网站资源没有得到有效使用,可能是由于结构和内容问题,这可能会对自然搜索中的网站性能产生负面影响。

简而言之:该网站真正的SEO潜力尚未得到充分发掘。 然而,更有效地管理站点的爬网程序预算需要一个步骤,而不仅仅是评估GCS数据和潜水日志文件,以确定Googlebot正在爬网哪些页面。

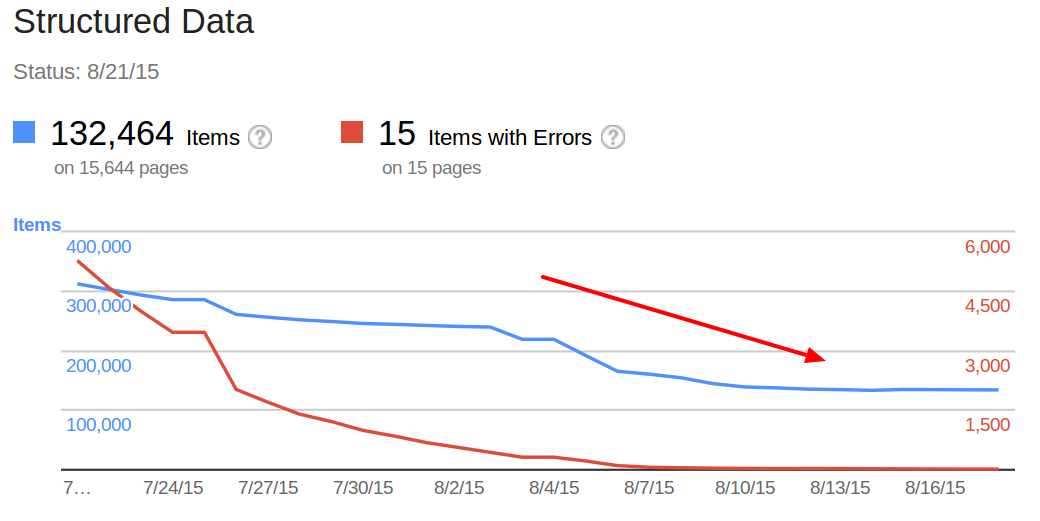

5. 结构化数据

除非最近的内容审查举措导致广泛的noindexing,否则站点范围的结构化数据(如结构化面包屑或组织架构)下降的理由很少。 将GSC中的结构化数据趋势与通过站点地图提交的两个页面以及实际索引的页面数量进行比较,可以成为站点运行状况指标。

再次显着的偏差可能表明结构化数据不一致,或者更糟糕的是,抓取和索引问题使网站重新进入自然搜索。

来自谷歌搜索控制台的所有SEO性能指标都允许一瞥大型网站在自然搜索中的表现,它们很少适用于无法提供足够数据得出任何可操作结论的小型网站。

重要的是要记住,虽然谷歌搜索控制台是一个不可或缺的免费搜索引擎优化数据源,但它绝不是故障安全的,提供的数据必须考虑一粒盐。 偶尔的尖峰,可能会或可能不会表明一个问题。

谷歌有时也会遇到问题。 同样,季节变化可能起作用,必须考虑在内。 重要的是要记住,任何对网站的改进都可能导致新的趋势在几周甚至几个月后变得可见。

上面提到的Google SEO性能指标是经过验证的SEO目标之一,没有大型网站可以忽视,并且可以根据google数据随时间得出可操作的结论。

外贸B2B建站

外贸B2B建站  高端定制设计

高端定制设计  系统功能优势

系统功能优势

Google SEO优化

Google SEO优化  Google SEM广告

Google SEM广告  网站内容营销

网站内容营销  优化案例

优化案例  设计赏析

设计赏析  搜索引擎优化

搜索引擎优化  付费广告

付费广告  社媒运营

社媒运营  公司介绍

公司介绍  渠道共赢

渠道共赢  联系我们

联系我们