什么是爬行预算?

抓取预算是在给定的时间段内,像Google这样的搜索引擎将抓取(发现)您网站上的Url数量。 在那之后,他们会继续前进。

事情是这样的:

世界上有数十亿个网站。 搜索引擎的资源有限-他们无法每天检查每个站点。 因此,他们必须优先考虑爬行的内容和时间。

在我们谈论他们是如何做到这一点之前,我们需要讨论为什么这对你的网站的搜索引擎优化很重要。

为什么爬行预算对搜索引擎优化很重要?

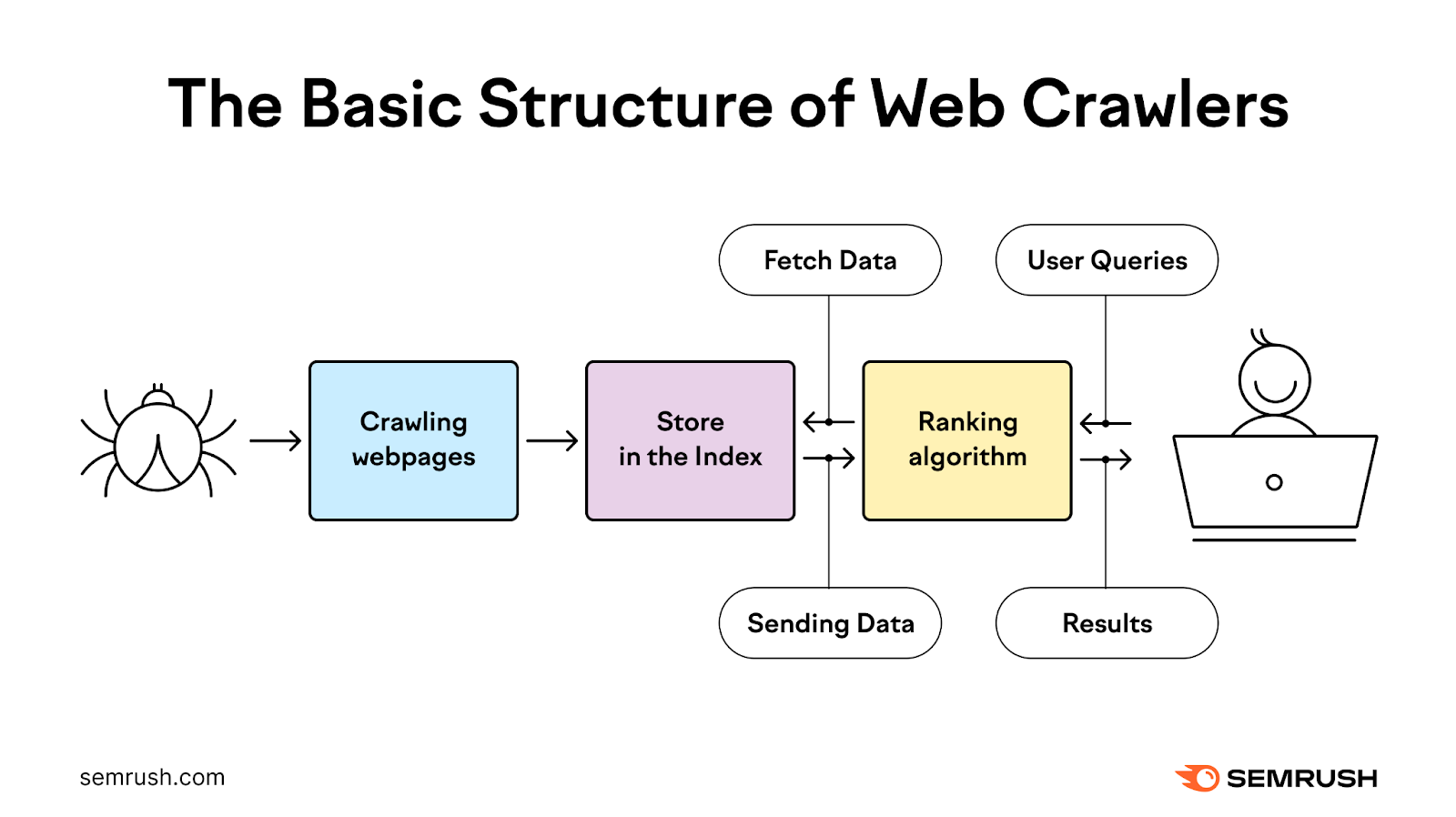

谷歌首先需要抓取,然后索引你的网页在他们排名之前。 一切都需要顺利进行这些过程,以便您的内容在搜索结果中显示。

这会对你的自然交通. 和您的整体业务目标。

大多数网站所有者不需要太担心爬行预算。 因为Google在抓取网站方面相当有效。

但有几个特定的情况下,当谷歌的抓取预算是SEO特别重要:

- 你的网站很大:如果您的网站庞大而复杂(10k+页面),Google可能无法立即找到新页面或经常重新整理您的所有页面

- 你增加了很多新的页面:如果您经常添加大量新页面,您的爬网预算可能会影响这些页面的可见性

- 您的网站有技术问题:如果可抓取性问题阻止搜索引擎高效抓取您的网站,您的内容可能不会显示在搜索结果中

Google如何确定预算?

您的爬网预算由两个主要元素决定:

爬网需求

抓取需求是Google根据感知的重要性抓取您网站的频率。 有三个因素会影响您网站的爬网需求:

感知库存

Google通常会尝试抓取它在您网站上了解的所有或大部分页面。 除非你指示谷歌不要。

这意味着Googlebot可能仍然会尝试抓取重复的页面和您删除的页面,如果您不告诉它跳过它们。 比如通过你的robots.txt文件(稍后更多)或404/410HTTP状态代码.

受欢迎程度

谷歌通常优先考虑更多的网页反向链接(从其他网站的链接)和那些吸引更高的流量,当涉及到爬行。 这两者都可以向Google的算法发出信号,表明您的网站很重要,值得更频繁地爬行。

请注意,反向链接的数量本身并不重要-反向链接应该是相关的,并且来自权威来源。

使用Semrush的反向链接分析工具,看看你的网页吸引最多的反向链接,并可能吸引谷歌的注意。

只需输入您的域名并点击"分析,分析.”

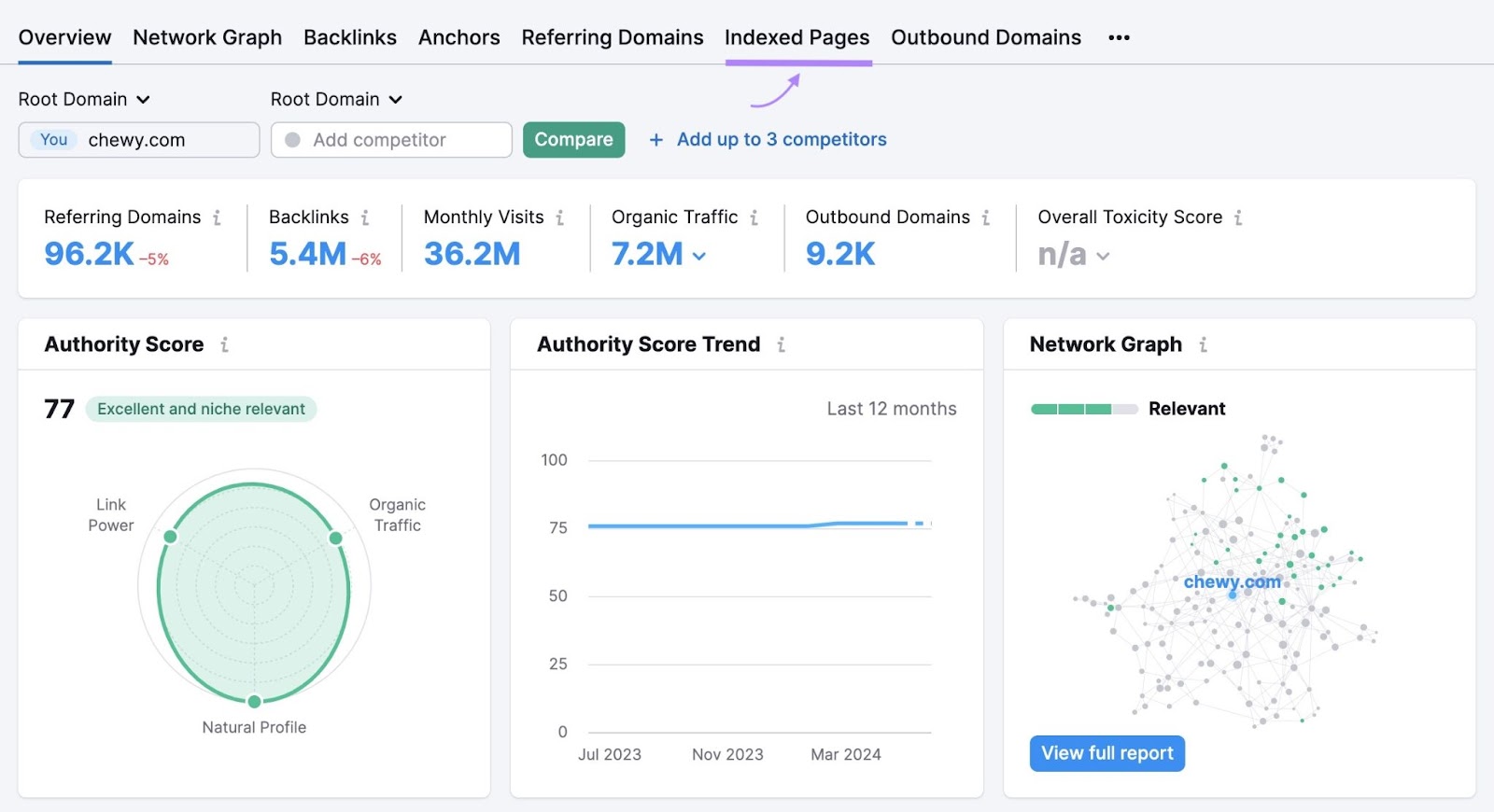

您将看到您网站的反向链接配置文件的概述。 但要按页面查看反向链接,请单击"索引页"tab。

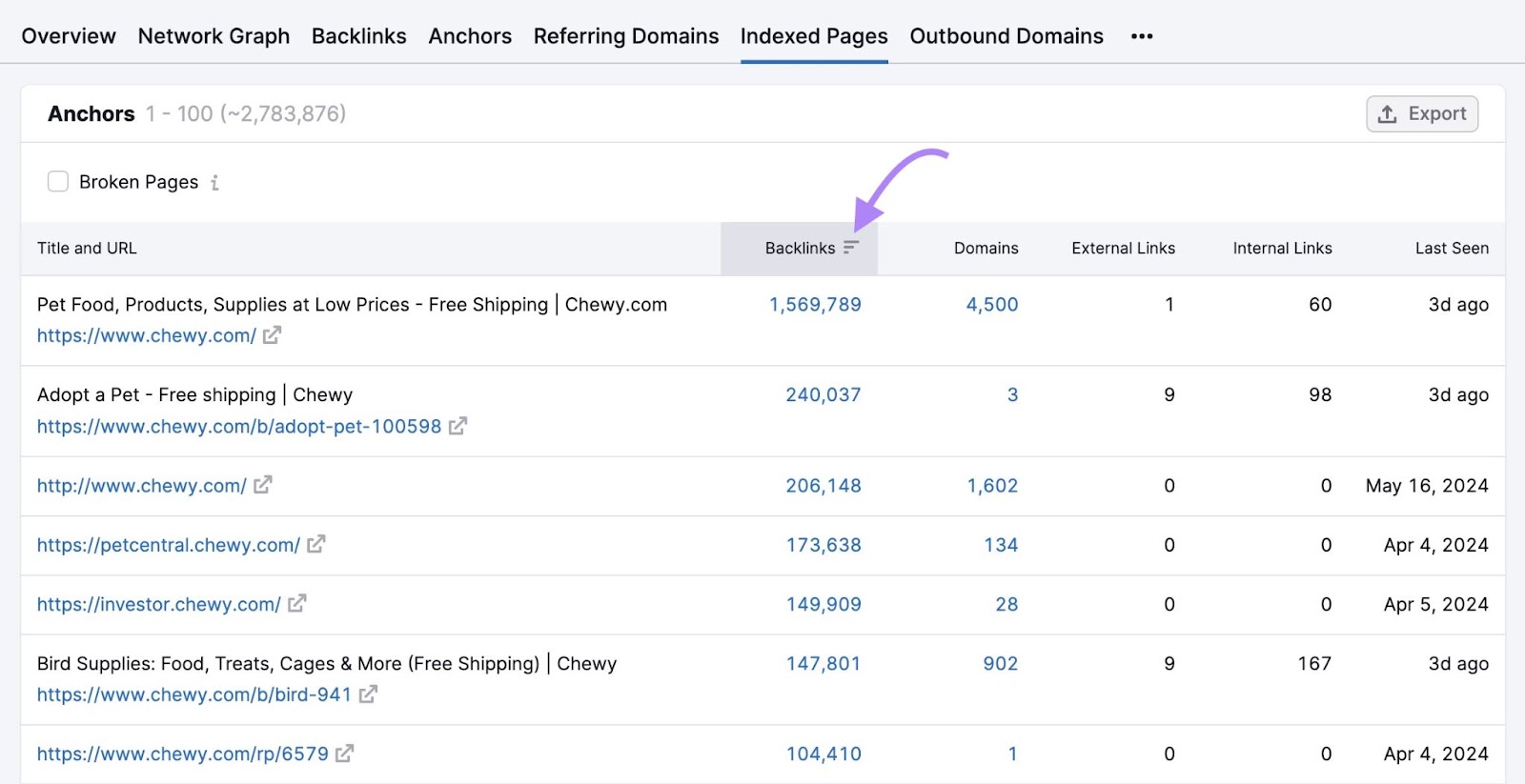

点击"反向链接"列按反向链接最多的页面进行排序。

这些可能是Google最常抓取的网站上的页面(尽管这不能保证)。

因此,请注意具有少量反向链接的重要页面—它们可能不太经常抓取。 并考虑实施一个反向链接策略以获得更多的网站链接到您的重要网页。

鹿Staleness

搜索引擎的目标是足够频繁地抓取内容以获取任何更改。 但是,如果您的内容随着时间的推移没有太大变化,Google可能会开始不那么频繁地抓取它。

例如,Google通常会大量抓取新闻网站,因为他们经常每天发布几次新内容。 在这种情况下,网站具有较高的抓取需求。

这并不意味着您需要每天更新您的内容,只是为了让Google更频繁地抓取您的网站。谷歌自己的指导说它只想抓取高质量的内容。

因此,优先考虑内容质量,而不是频繁地进行不相关的更改,以提高爬网频率。

爬网容量限制

爬网容量限制可防止Google的机器人通过太多请求减慢您的网站速度,这可能会导致性能问题。

它主要受您网站的整体健康状况和Google自己的爬行限制的影响。

你的网站的爬行健康

您的网站对Google请求的响应速度可能会影响您的抓取预算。

如果您的站点快速响应,您的爬网容量限制可能会增加。 Google可能会更快地抓取您的网页。

但是,如果您的网站速度变慢,您的爬网容量限制可能会降低。

如果您的站点响应服务器错误,这也可以减少限制。 而Google可能会更少地抓取您的网站。

谷歌的爬行限制

Google没有无限的资源来花费抓取网站。 这就是为什么有爬行预算摆在首位。

基本上,这是Google优先考虑最常抓取哪些页面的一种方式。

如果Google的资源由于某种原因而受到限制,这可能会影响您网站的抓取容量限制。

如何检查爬网活动

谷歌搜索控制台(GSC)提供有关Google如何抓取您的网站的完整信息。 随着时间的推移,爬行行为可能会出现任何问题和任何重大变化。

这可以帮助您了解是否存在影响您可以修复的爬网预算的问题。

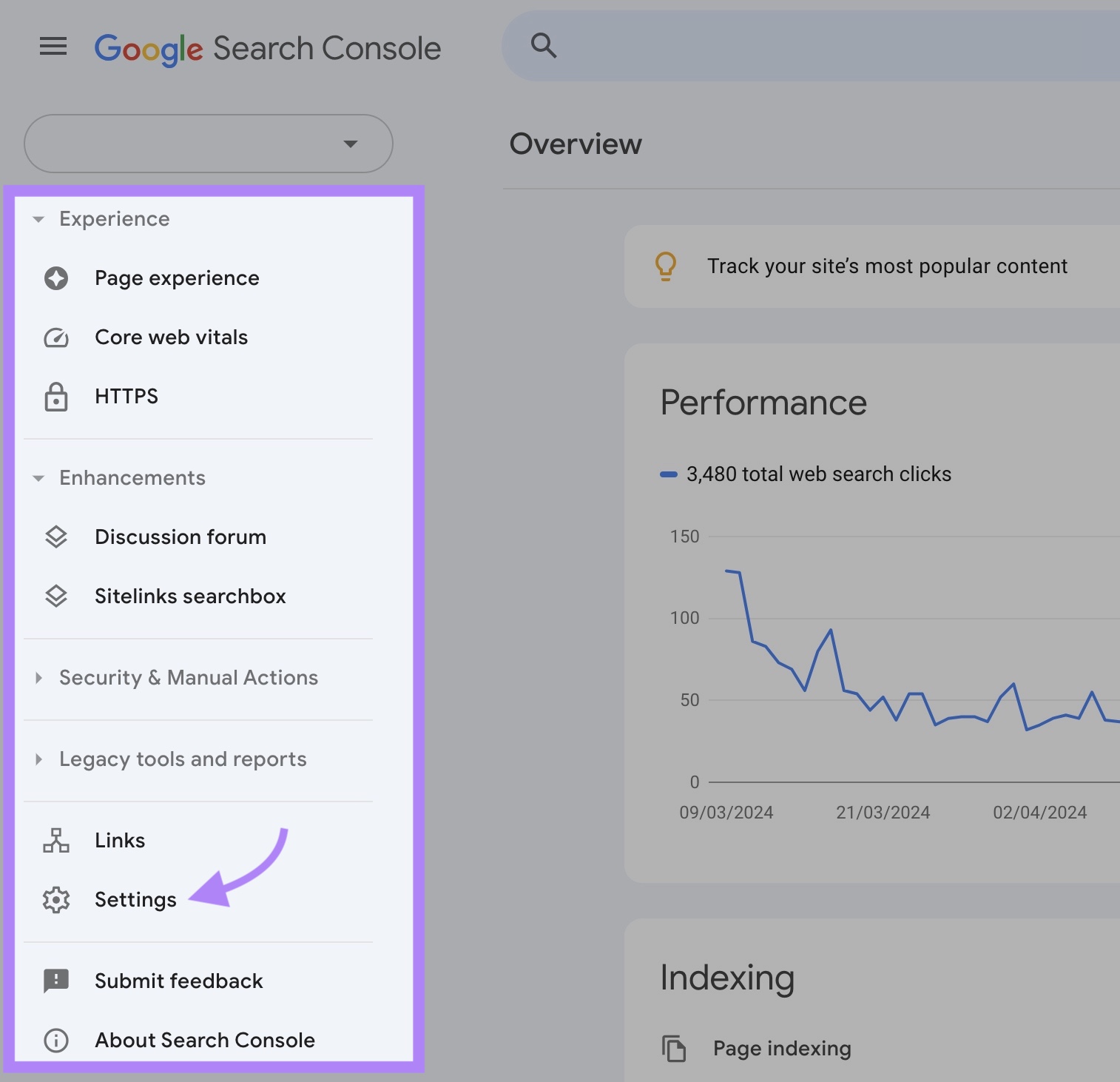

要查找此信息,请访问您的GSC属性并单击"设置.”

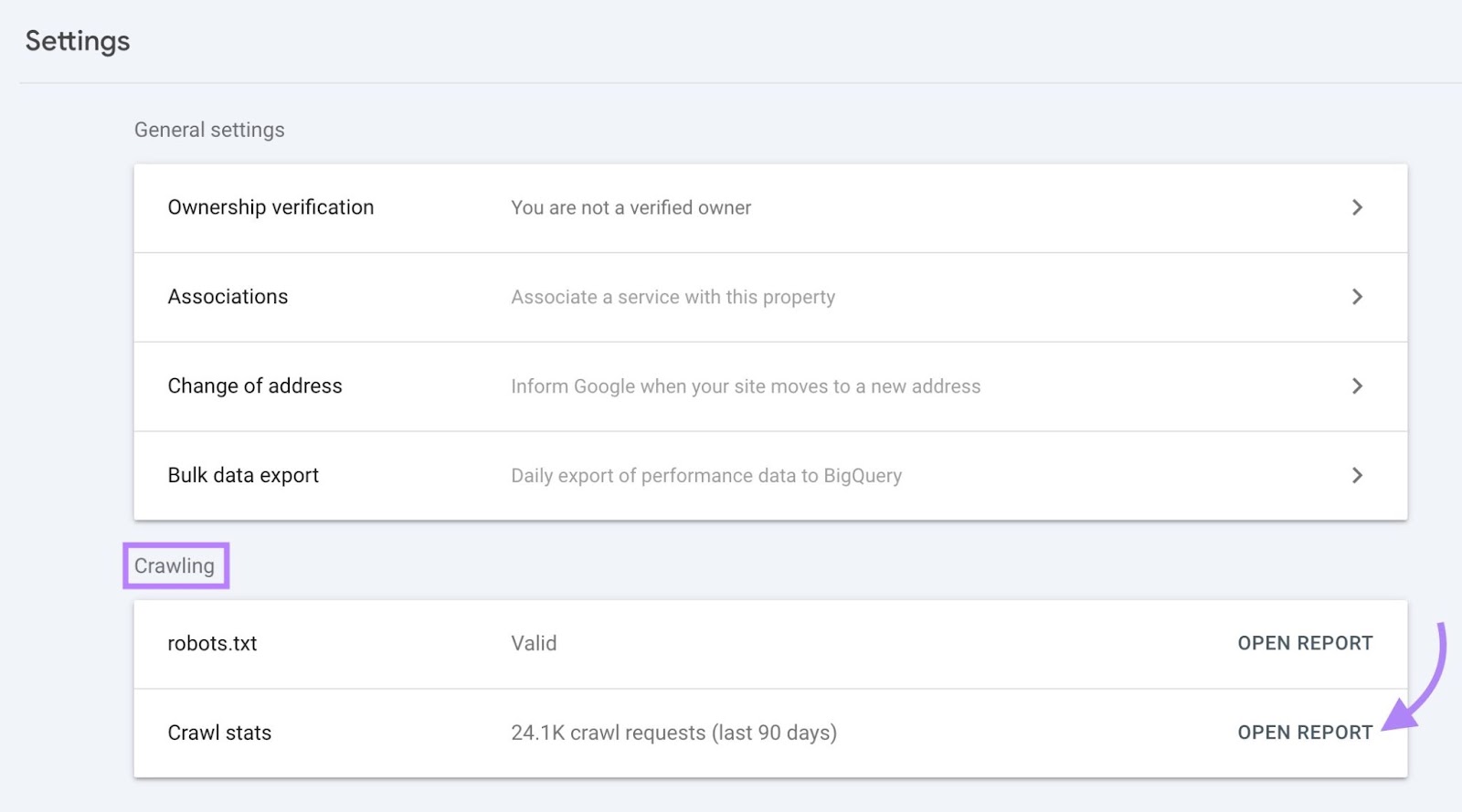

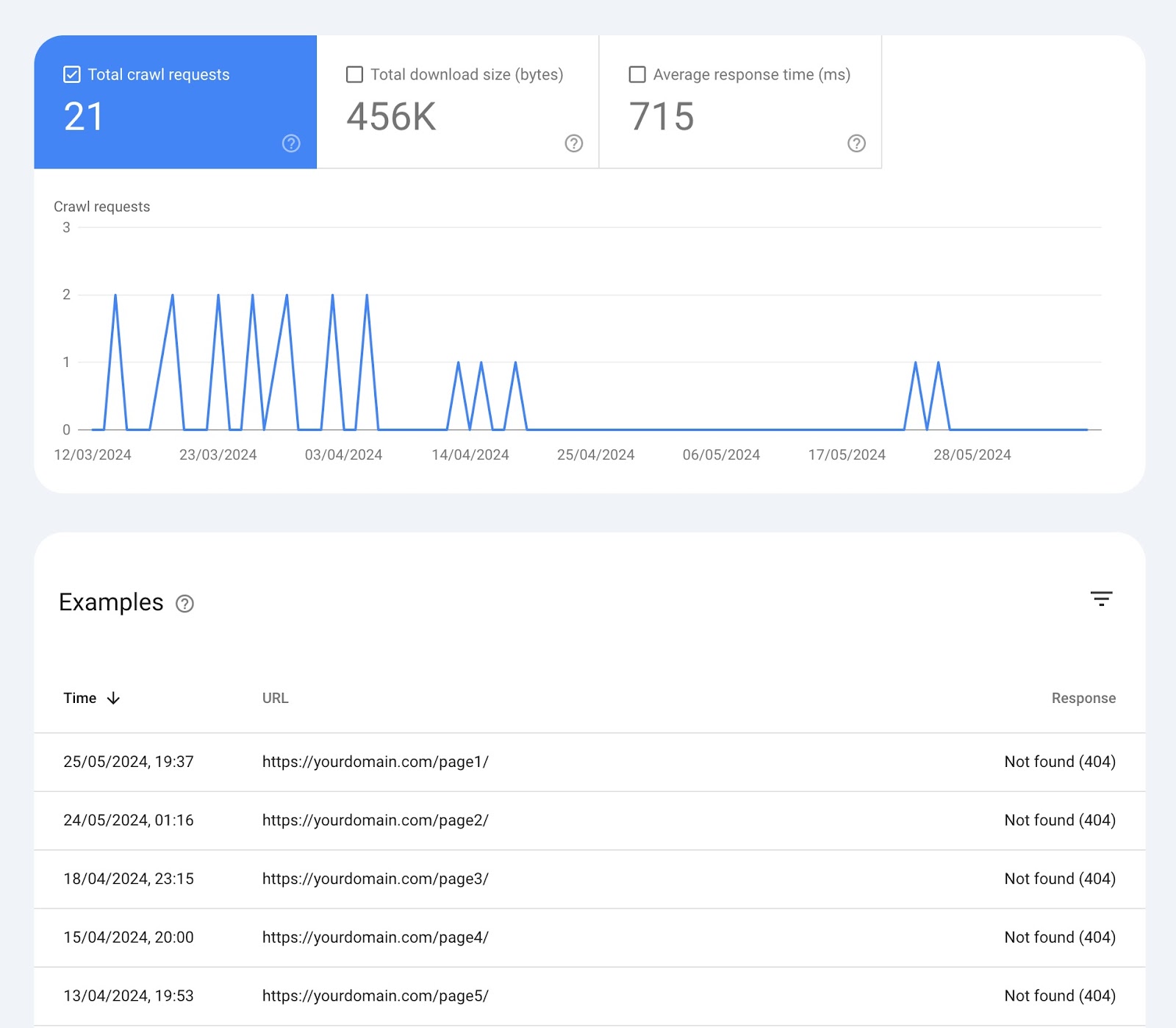

在"爬网"部分,您将看到过去90天内的爬网请求数量。

点击"公开报告"以获得更详细的见解。

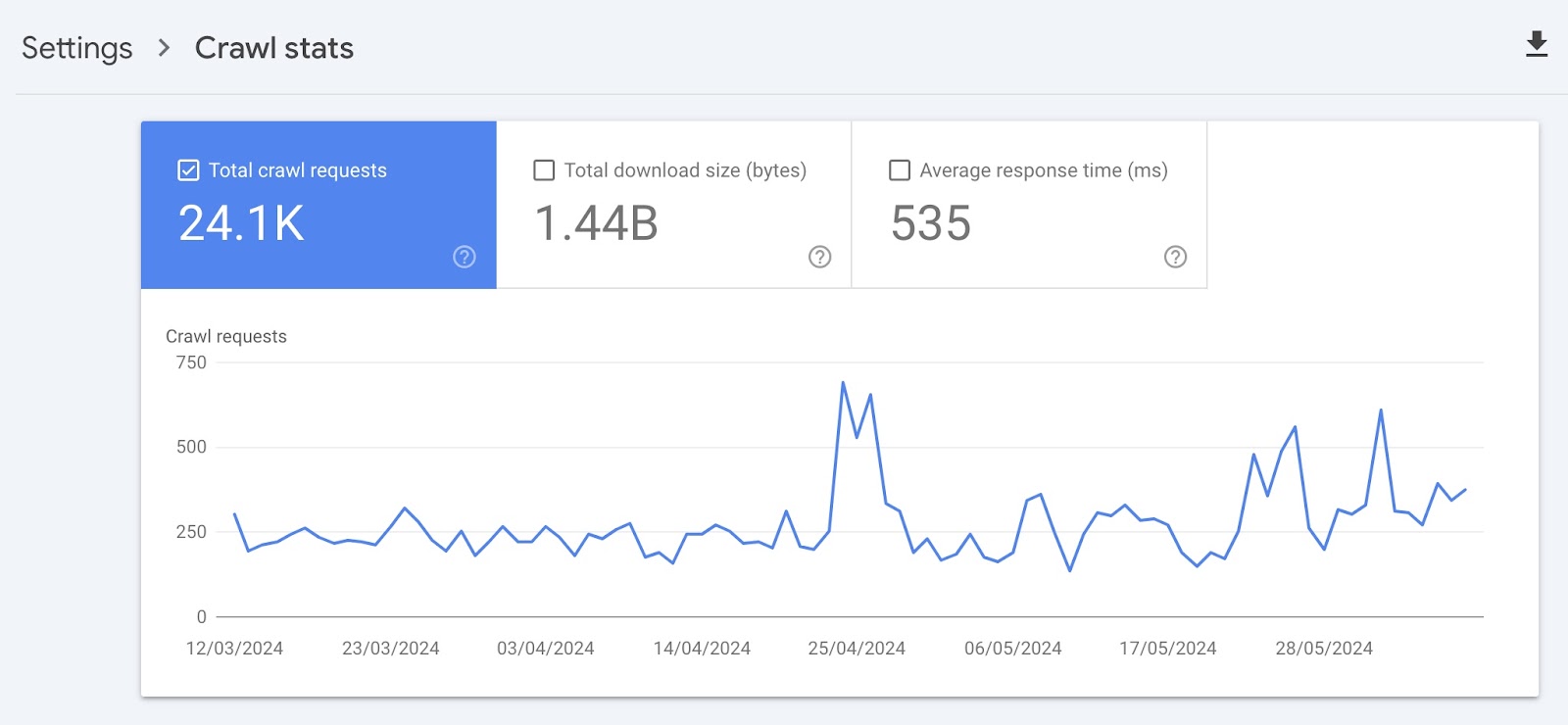

"爬网统计"页面向您显示带有数据的各种小部件:

超时图表

在顶部,有一个Google在过去90天内对您的网站进行的抓取请求图表。

下面是顶部的每个盒子的含义:

- 爬网请求总数:Google在过去90天内提出的抓取请求数量

- 总下载大小:Google的爬虫在特定时间段内访问您的网站时下载的数据总量

- 平均响应时间:网站服务器响应爬虫请求所花费的平均时间(以毫秒为单位)

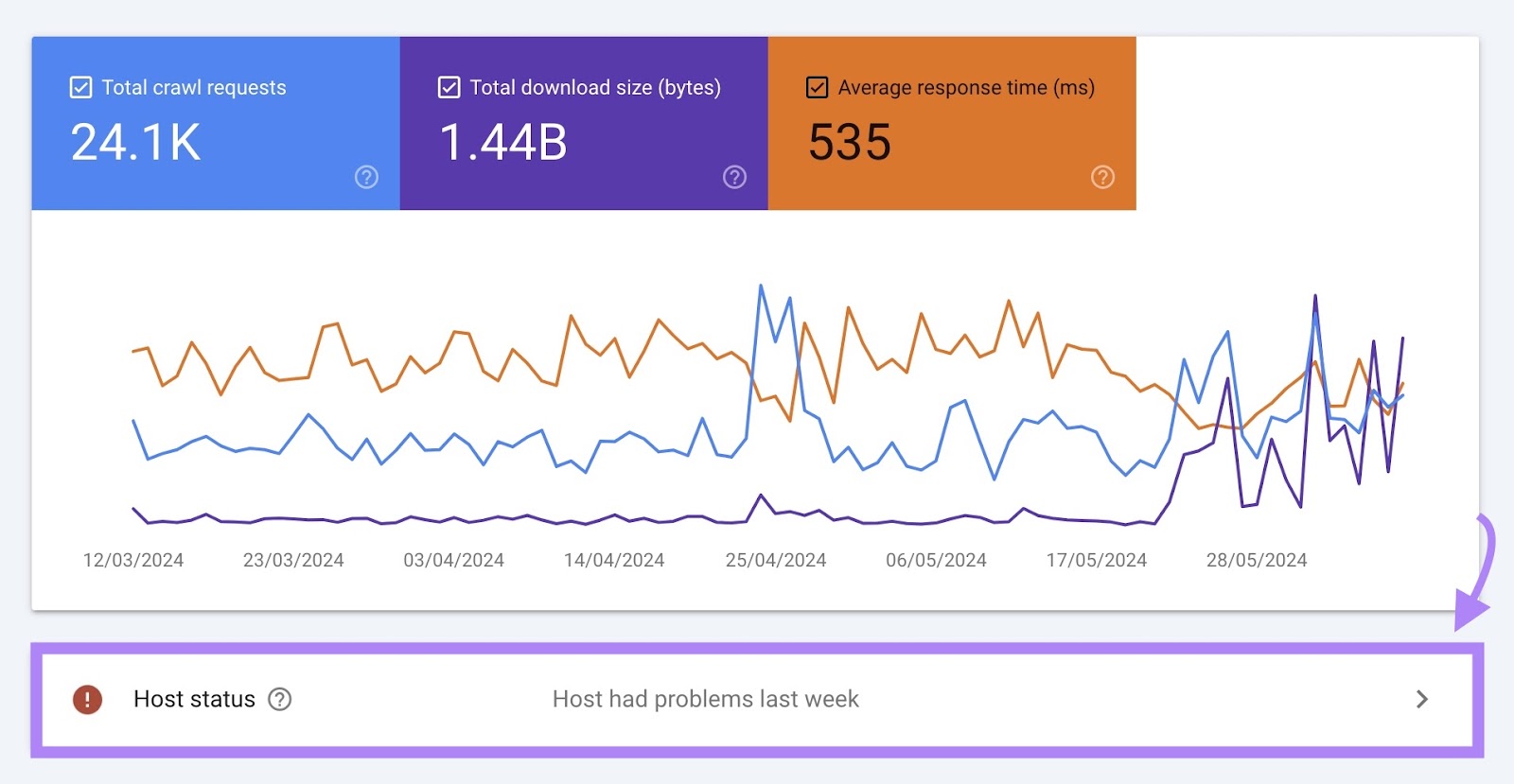

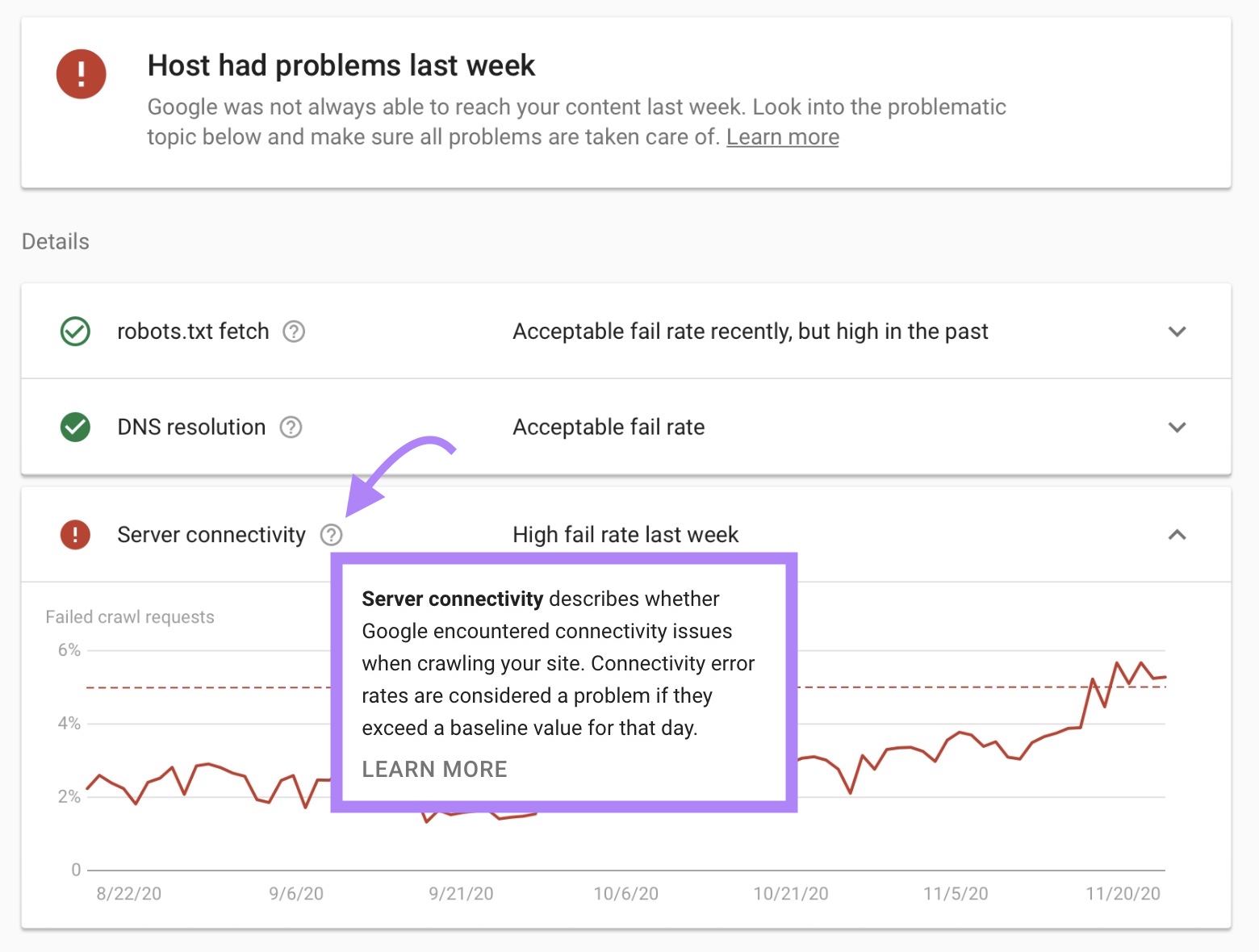

主机状态

主机状态显示Google可以轻松抓取您的网站。

例如,如果您的网站并不总是能够满足Google的爬网需求,您可能会看到消息"主机过去遇到问题。”

如果有任何问题,您可以通过单击此框查看更多详细信息。

在"详细信息"下,您将找到有关问题发生原因的更多信息。

这将告诉你是否有任何问题:

- 拿你的robots.txt文件

- 您的域名系统(DNS)

- 服务器连接

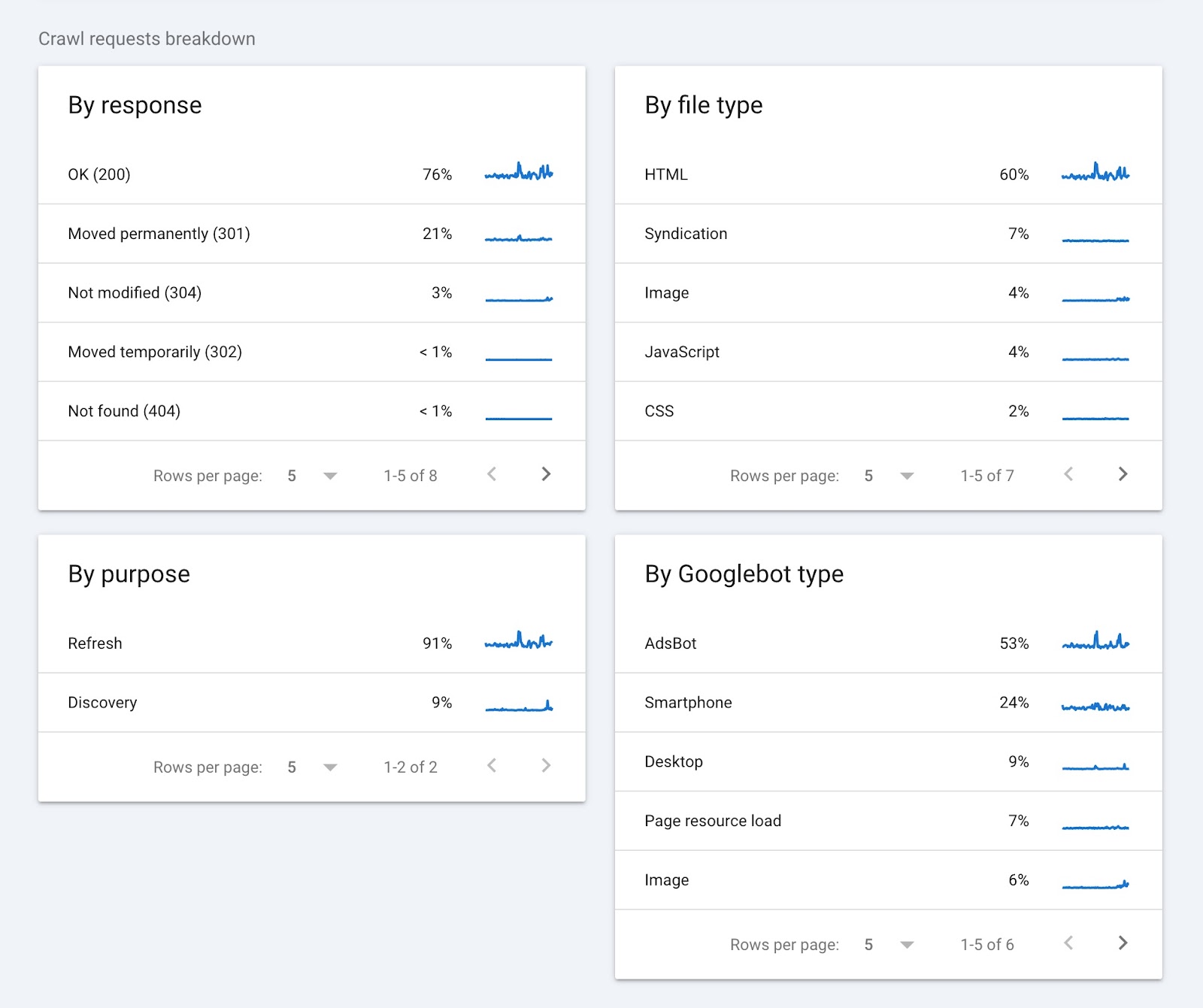

爬网请求细分

报告的本部分提供有关爬网请求的信息,并根据以下条件对它们进行分组:

- 回应(例如,"OK(200)"或"Not found(404)"

- URL文件类型(例如HTML或图像)

- 请求的目的(新页面的"发现"或现有页面的"刷新")

- Googlebot型(例如,智能手机或台式机)

单击每个小部件中的任何项目将显示更多详细信息。 如返回特定状态代码的页面。

谷歌搜索控制台可以直接从源提供有关爬网预算的有用信息。 但其他工具可以提供更详细的见解,您需要改进您的网站可爬行性.

如何分析您网站的可抓取性

semrush氏现场审核工具显示您的爬行预算被浪费的地方,并可以帮助您优化您的网站爬行。

以下是如何开始:

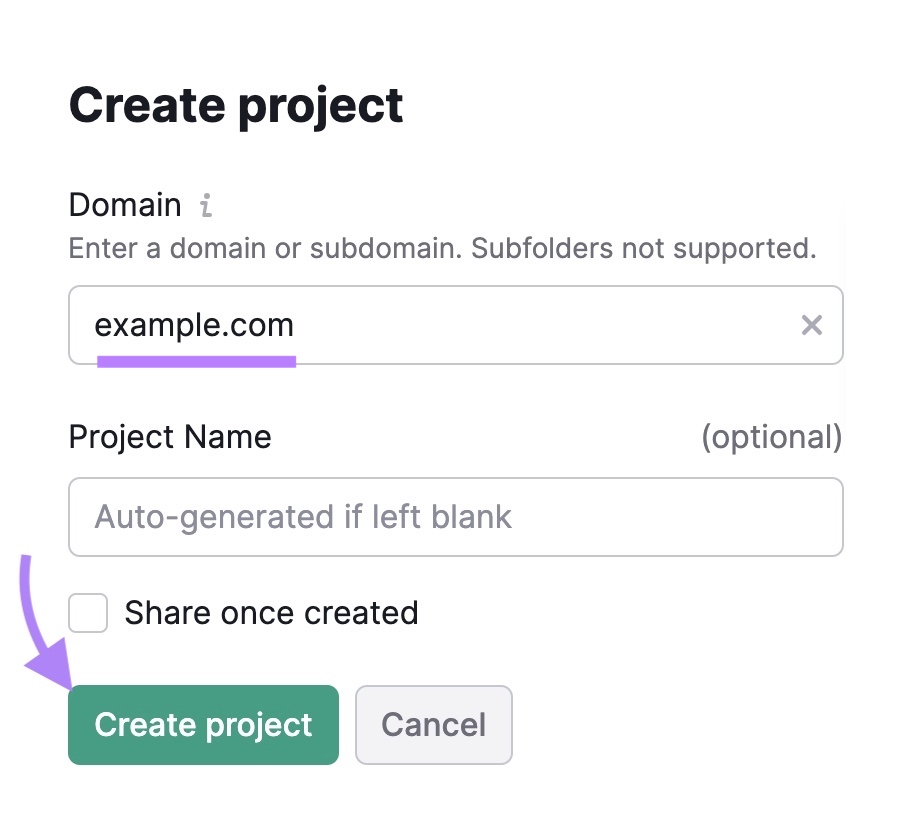

打开现场审核工具。 如果这是您的第一次审核,则需要创建一个新项目。

只需输入您的域,给项目一个名称,然后单击"创建项目.”

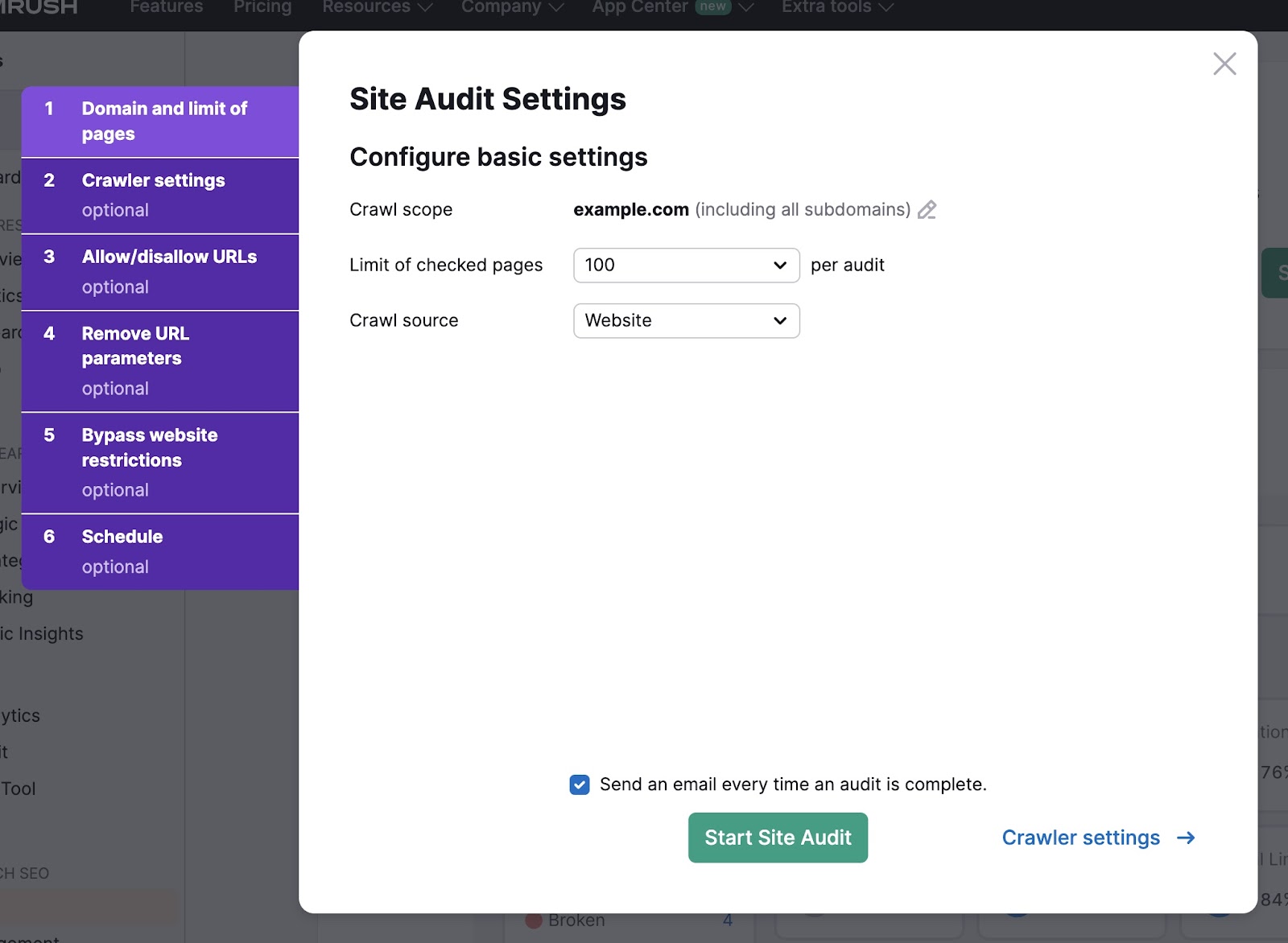

接下来,选择要检查的页数和爬网源。

如果您希望该工具直接抓取您的网站,请选择"网站"作为抓取源。 或者,您可以上传站点地图或Url文件。

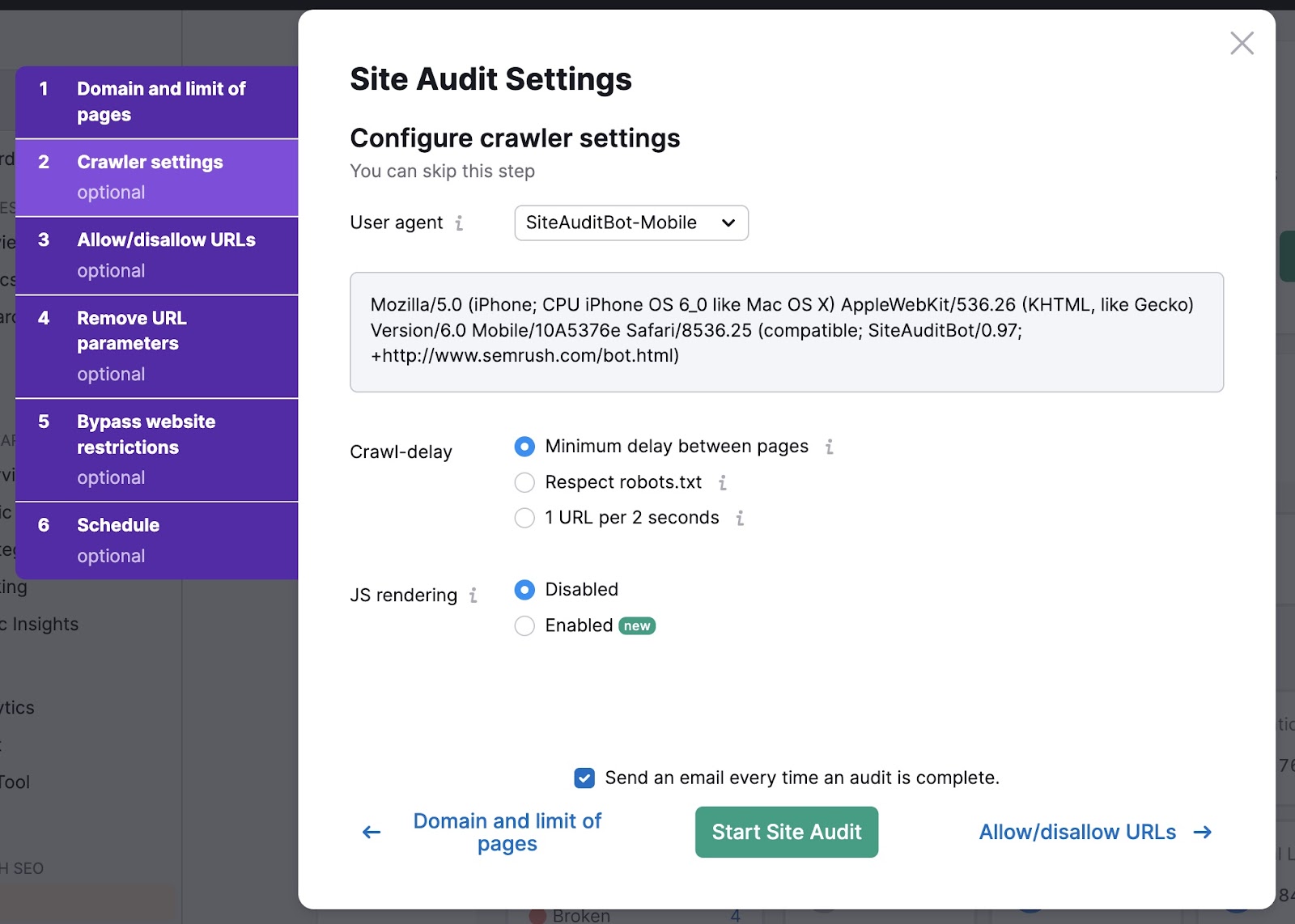

在"爬网程序设置"选项卡中,使用下拉列表选择用户代理。 在GoogleBot和SiteAuditBot之间进行选择。 和移动和桌面版本中的每一个。

然后选择您的爬网延迟设置。 通常建议使用"页面之间的最小延迟"选项—这是审核网站的最快方法。

最后,决定是否要启用JavaScript(JS)渲染。 JavaScript渲染允许爬虫看到与网站访问者相同的内容。

这提供了更准确的结果,但可能需要更长的时间才能完成。

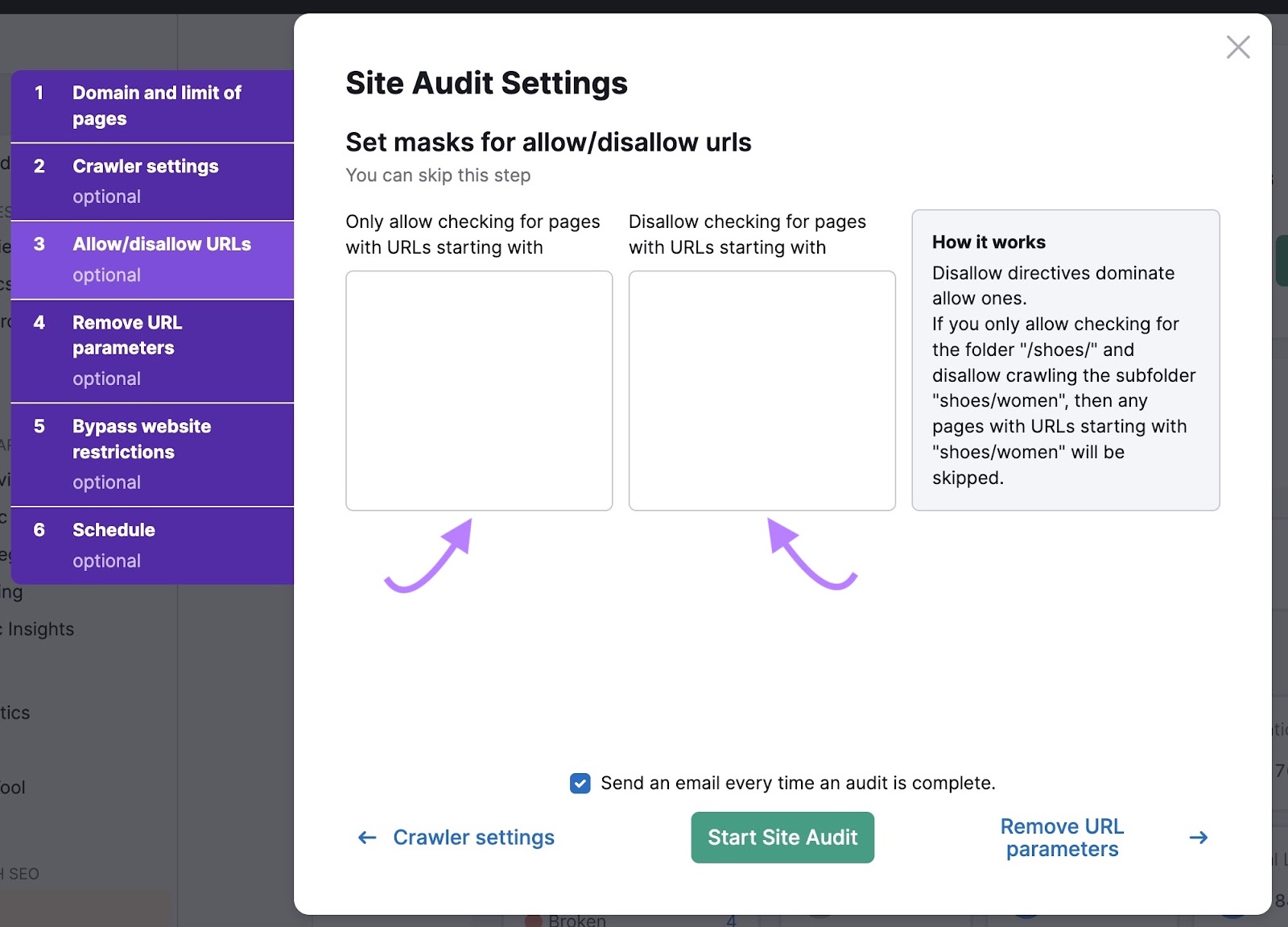

然后,点击"允许-禁止Url.”

如果您希望爬虫只检查某些Url,则可以在此处输入它们。 您还可以不允许Url指示爬网程序忽略它们。

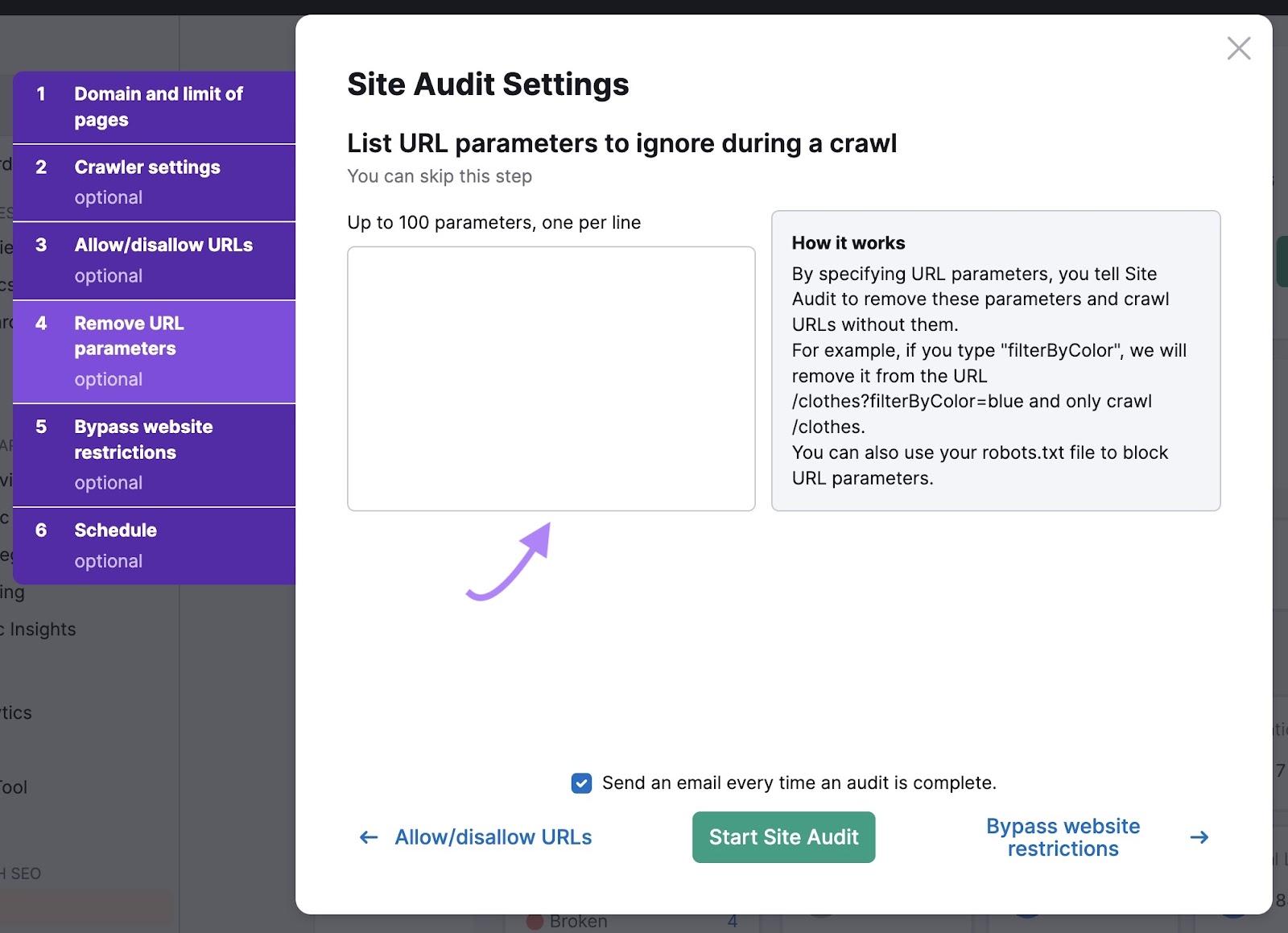

接下来,列表URL参数告诉机器人忽略同一页面的变化。

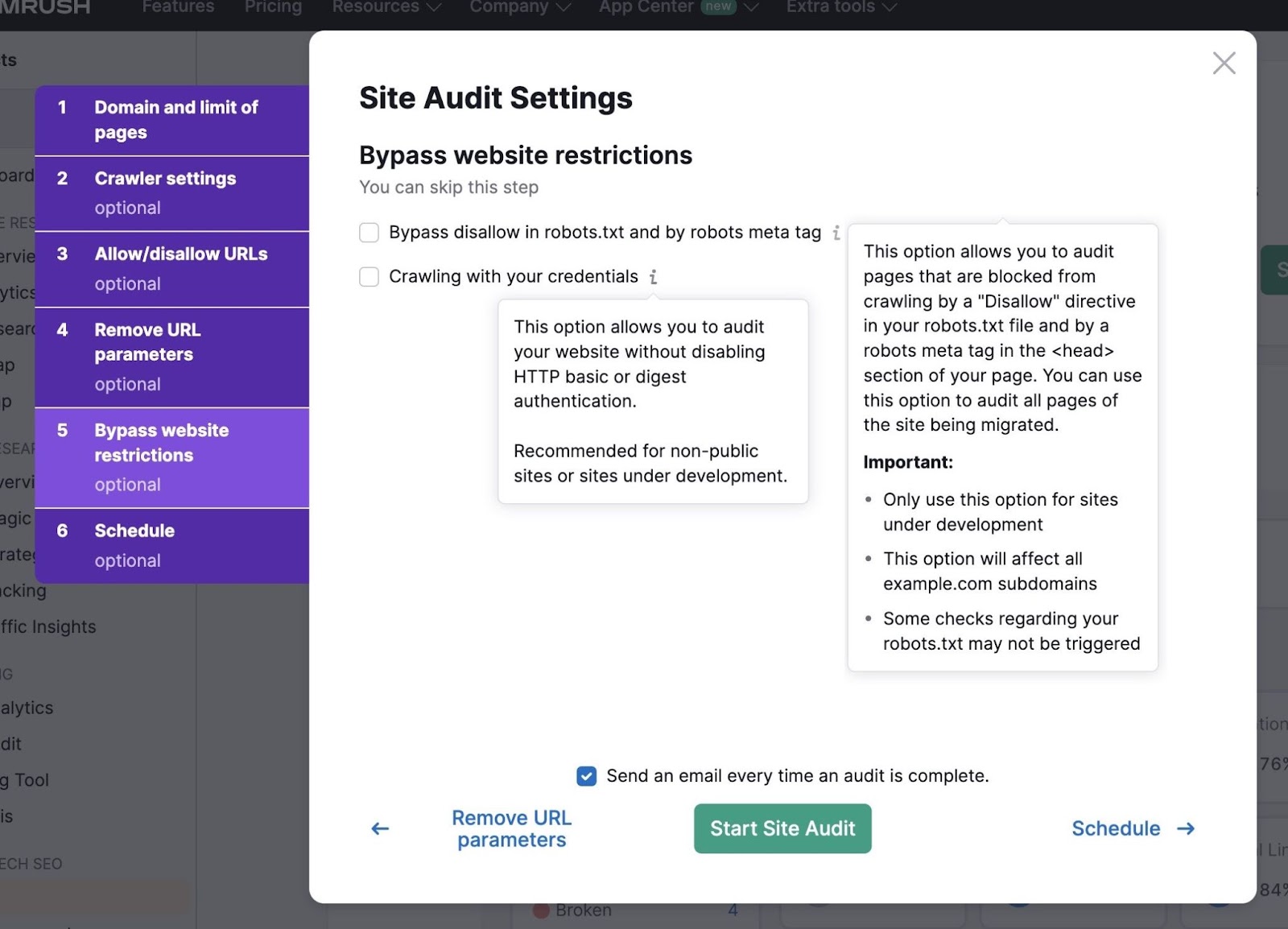

如果您的网站仍在开发中,则可以使用"绕过网站限制"设置来运行审核。

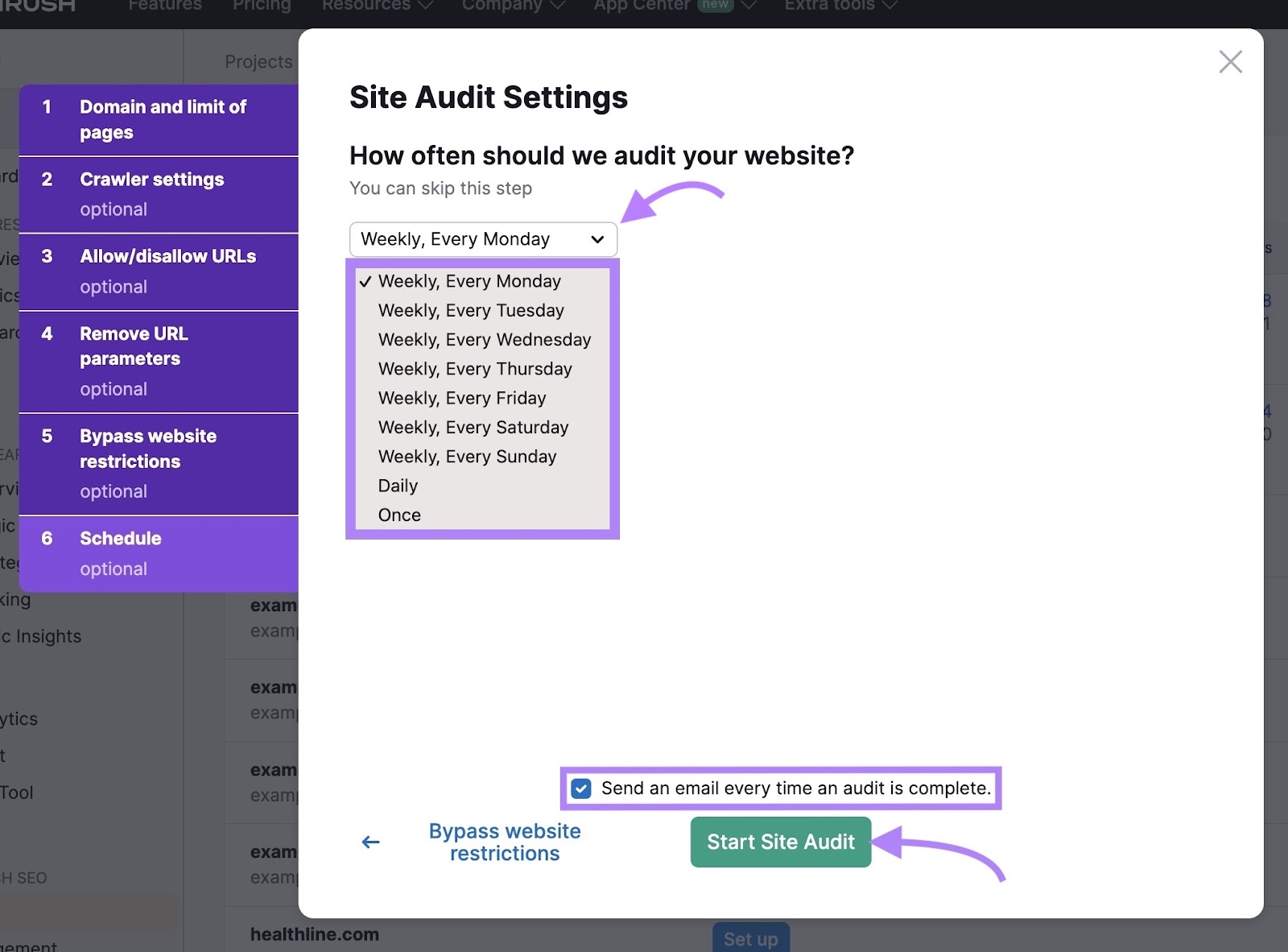

最后,安排您希望该工具审核您网站的频率。 定期审核是关注网站健康状况的好主意。 并在早期标记任何可抓取性问题。

勾选审核完成后通过电子邮件通知的复选框。

当你准备好了,点击"开始现场审核.”

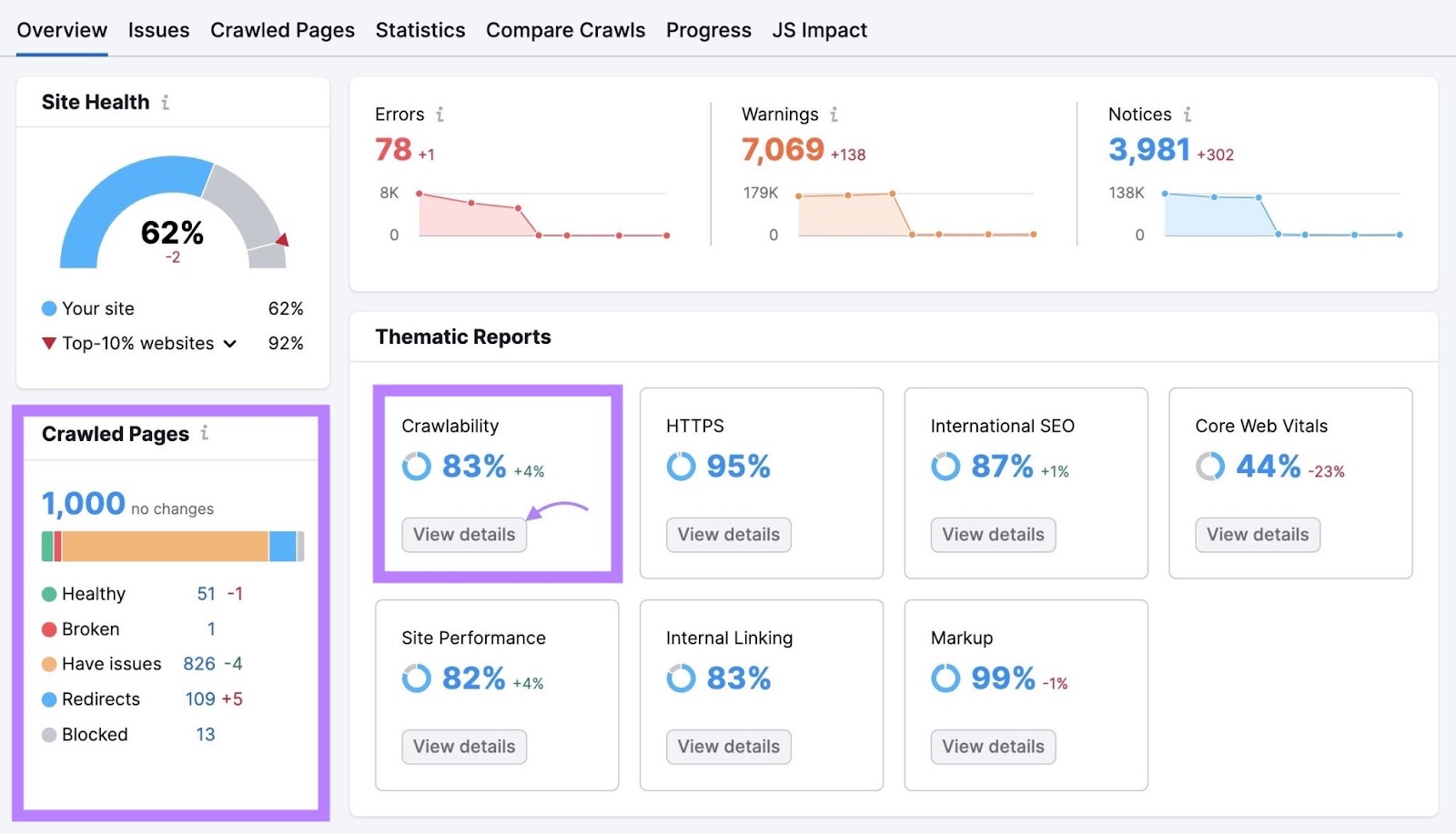

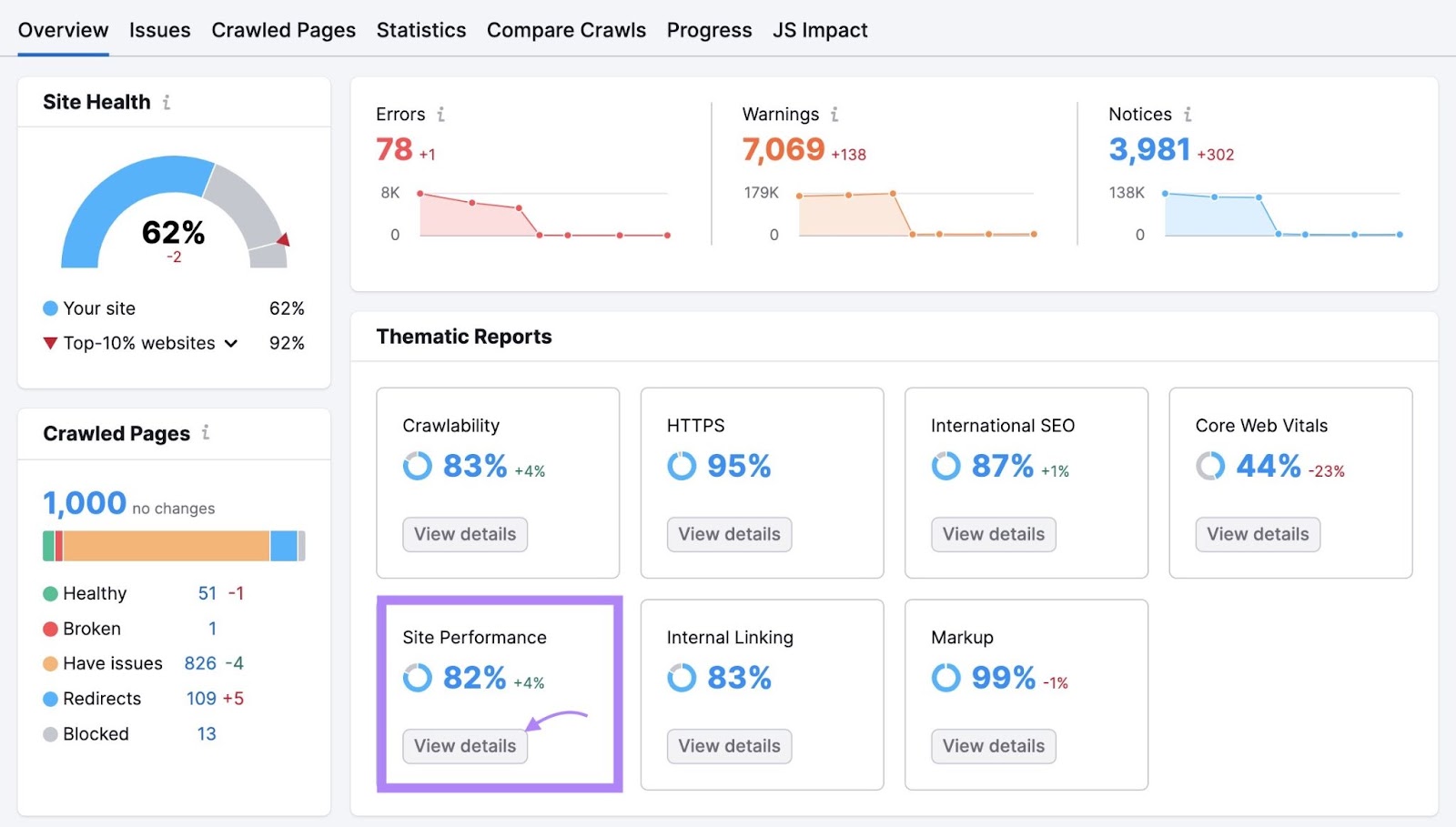

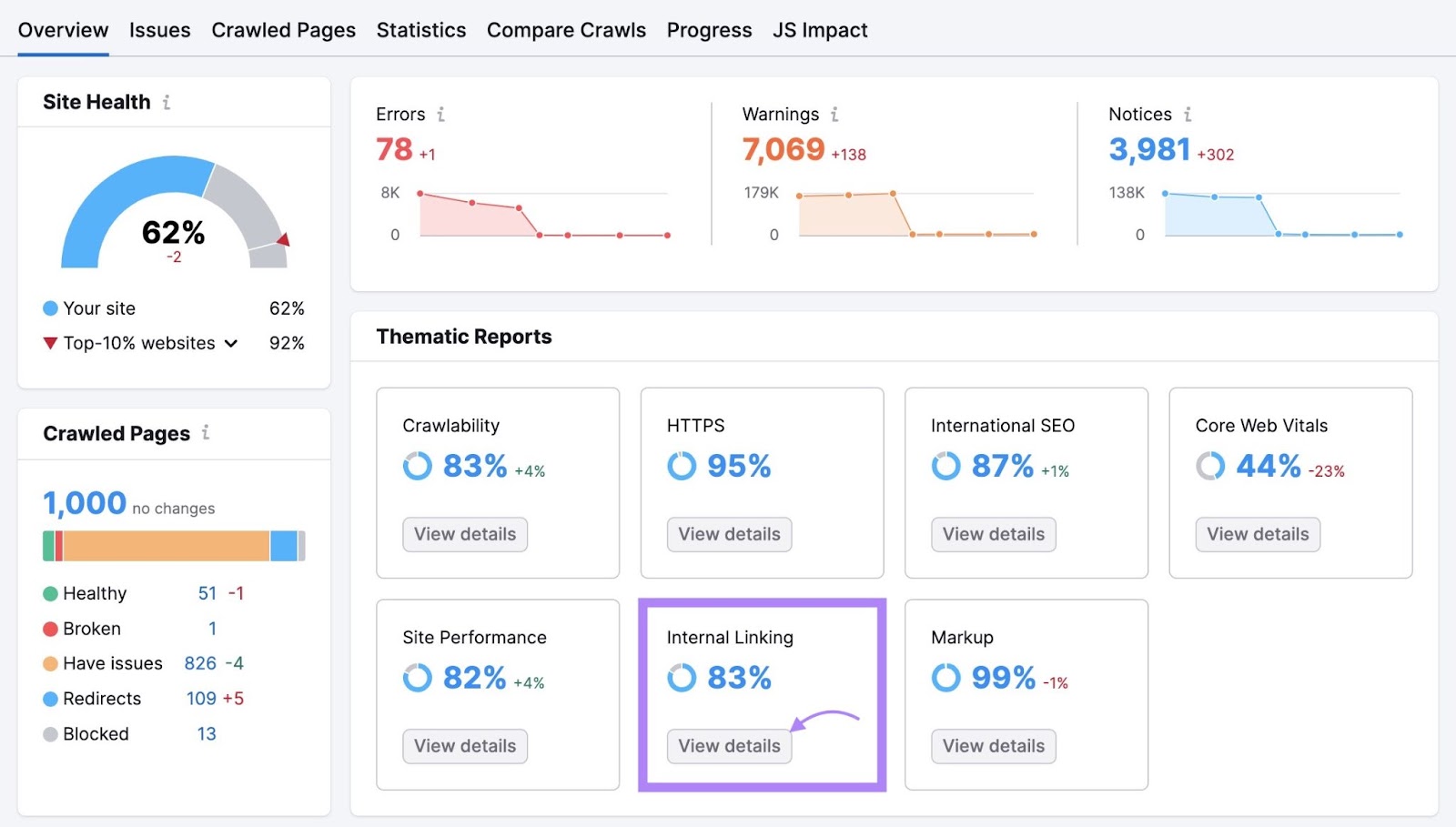

站点审核"概述"报告汇总了爬虫程序在爬网过程中收集的所有数据。 并为您提供有关网站整体健康状况的有价值信息。

"已爬网页面"小部件会告诉您该工具爬网了多少页面。 并给出了有多少页面是健康的,有多少有问题的细分。

要获得更深入的见解,请导航到"可抓取性"部分,然后单击"查看详情.”

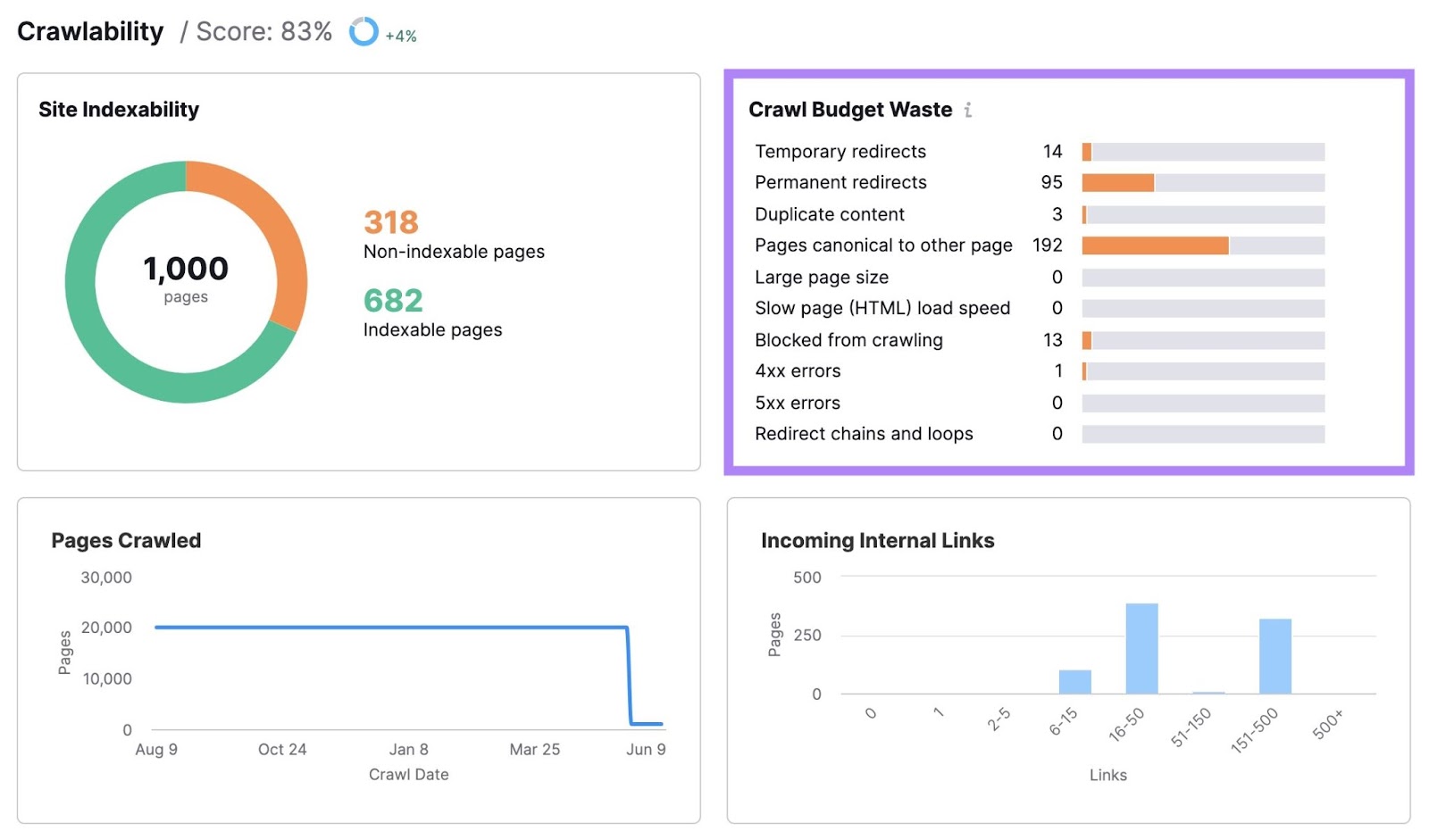

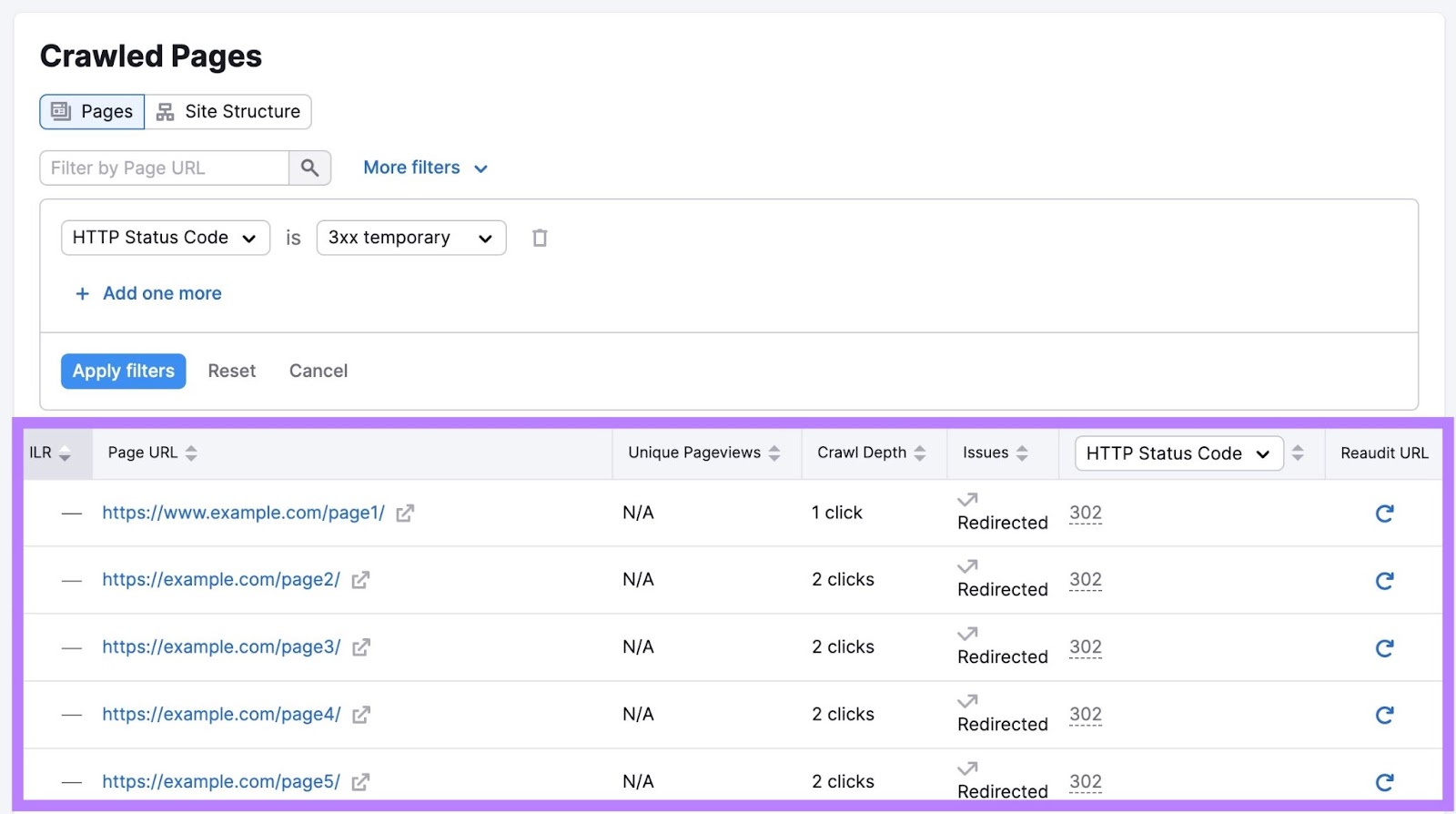

在这里,您会发现您的网站的爬网预算浪费了多少,以及有哪些问题阻碍了您的网站。 如临时重定向,永久重定向,重复内容和加载速度慢。

单击任何一个栏将显示有该问题的页面列表。

根据问题,您将在每个受影响页面的不同列中看到信息。

浏览这些页面并修复相应的问题。 提高网站的可抓取性。

爬网预算优化的7个技巧

一旦您知道网站的爬网预算问题在哪里,您就可以修复它们以最大限度地提高爬网效率。

以下是您可以做的一些主要事情:

1. 提高您的网站速度

改善你的网站速度可以帮助Google更快地抓取您的网站。 这可以导致更好地使用您的网站的爬网预算。 另外,这对......用户体验(UX)和SEO.

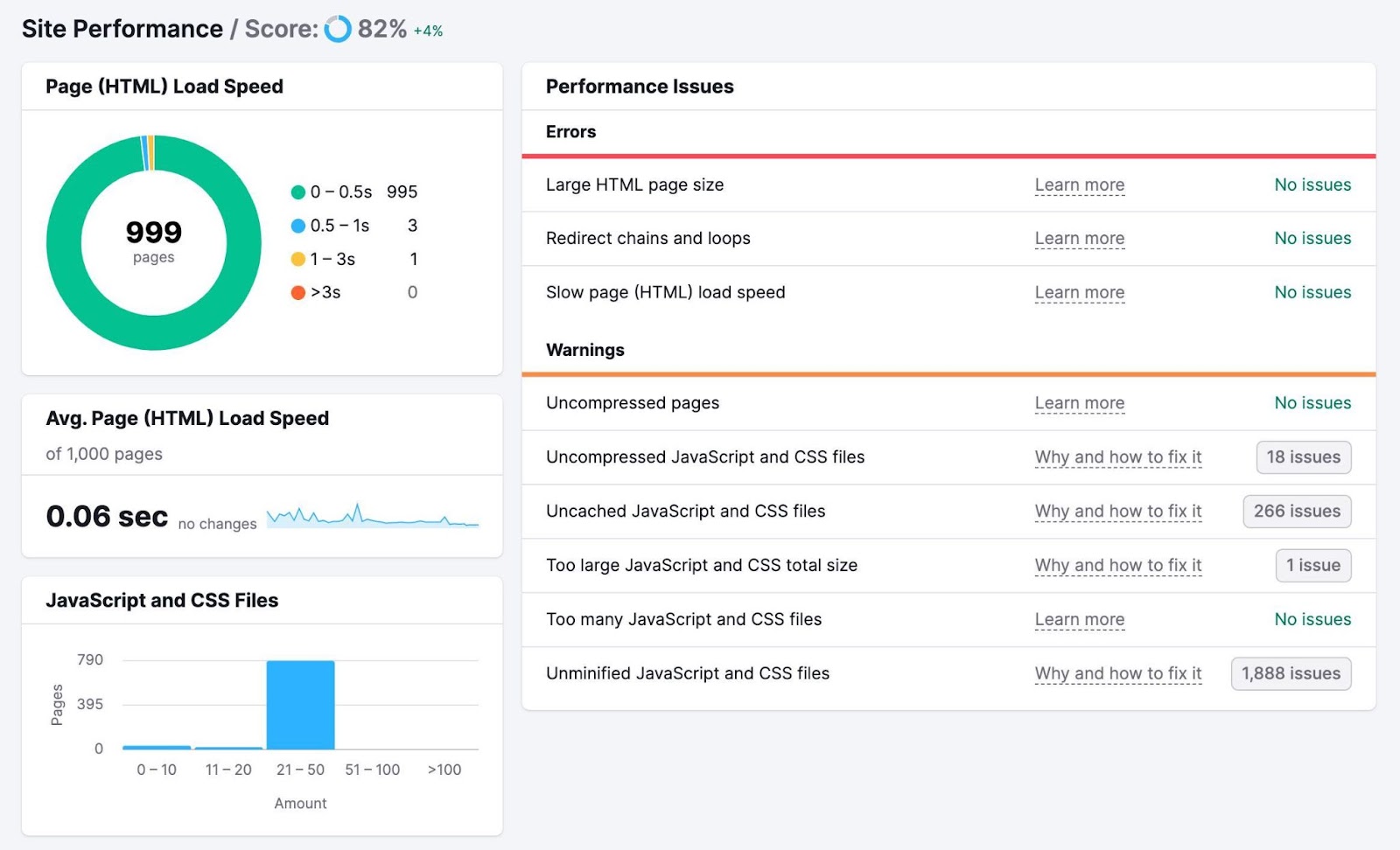

要检查页面加载速度,请返回您之前设置的站点审核项目,然后单击"查看详情"在"站点性能"框中。

您将看到页面加载速度和平均页面加载速度的细分。 以及可能导致性能不佳的错误和警告列表。

有很多方法可以提高您的页面速度,包括:

- 优化您的图像:使用在线工具,如图像压缩器在不使图像模糊的情况下减少文件大小

- 最小化代码和脚本:考虑使用在线工具,如Minifier.org或者像这样的WordPress插件可湿性粉剂火箭缩小网站代码以加快加载速度

- 使用内容分发网络(CDN):ACDN是一个分布式网络的服务器,根据用户的位置向用户提供web内容,以提高加载速度

2. 使用战略内部链接

一个聪明的内部链接结构可以使搜索引擎爬虫更容易找到并理解您的内容。 这可以更有效地使用您的爬行预算和增加您的排名潜力。

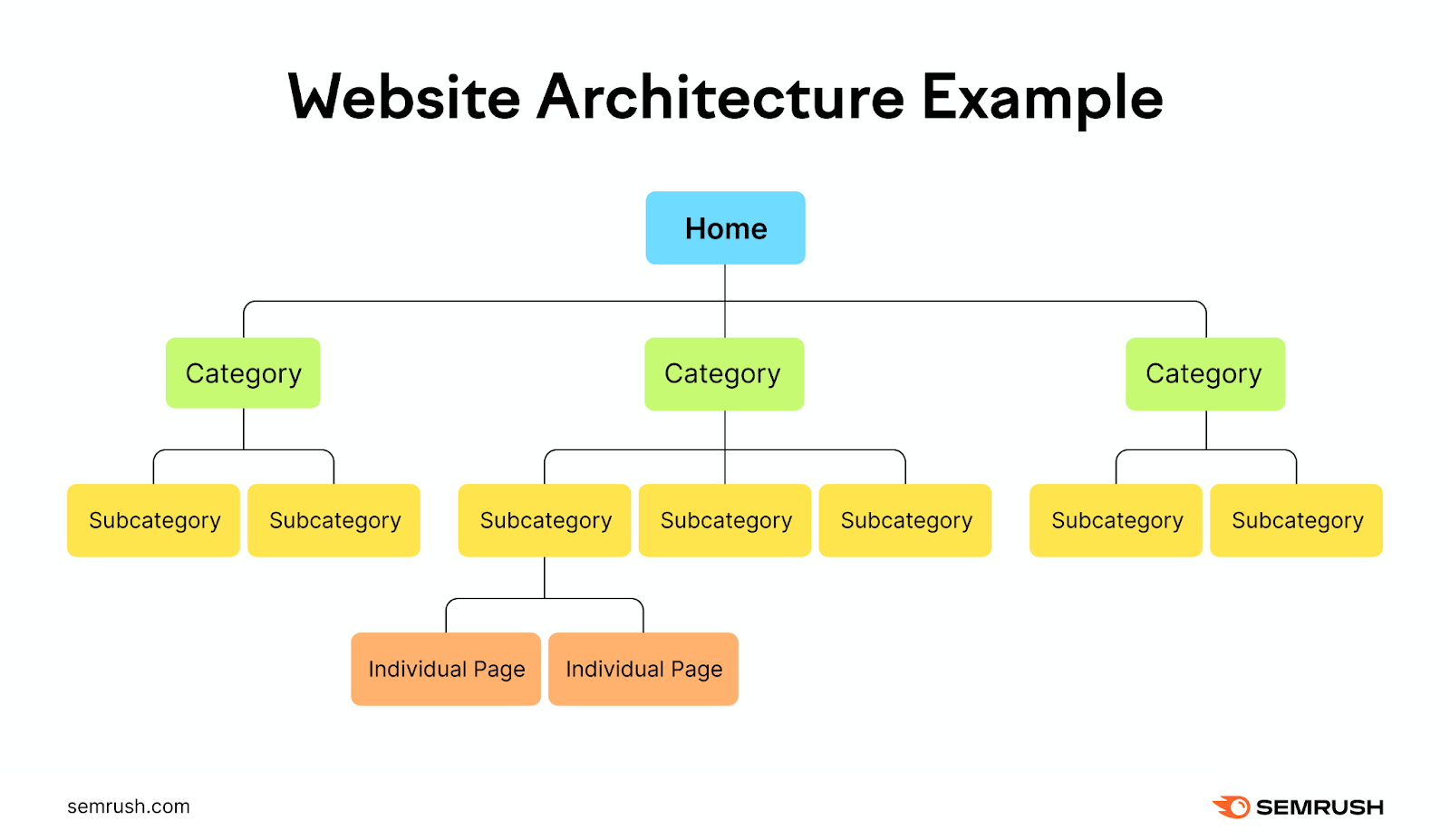

想象一下你的网站是一个层次结构,主页在顶部. 然后分支到不同的类别和子类别。

每个分支都应该导致与其所属类别相关的更详细的页面或帖子。

这为您的网站创建了一个清晰的逻辑结构,便于用户和搜索引擎导航。

为所有重要页面添加内部链接,使Google更容易找到您最重要的内容。

这也有助于您避免孤立页面-没有指向它们的内部链接的页面。 Google仍然可以找到这些页面,但如果您有指向它们的相关内部链接,则会容易得多。

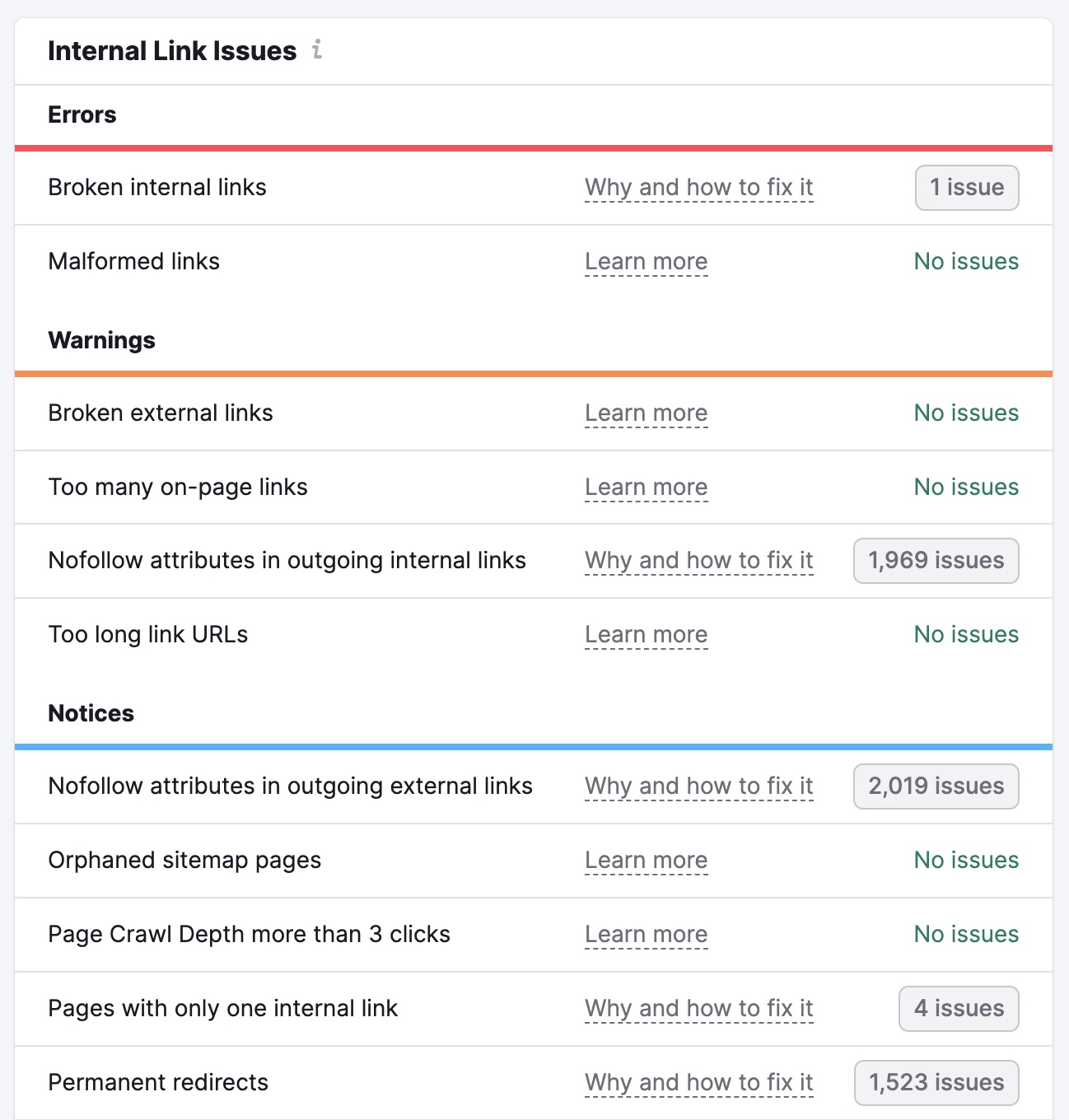

点击"查看详情"在您的"内部链接"框中现场审核项目发现问题与您的内部链接。

您将看到网站内部链接结构的概述。 包括从主页访问每个页面所需的点击次数。

您还将看到错误、警告和通知的列表。 这些问题包括损坏的链接,内部链接上的nofollow属性,以及没有锚文本的链接。

通过这些并纠正每页上的问题。 使搜索引擎更容易抓取和索引您的内容。

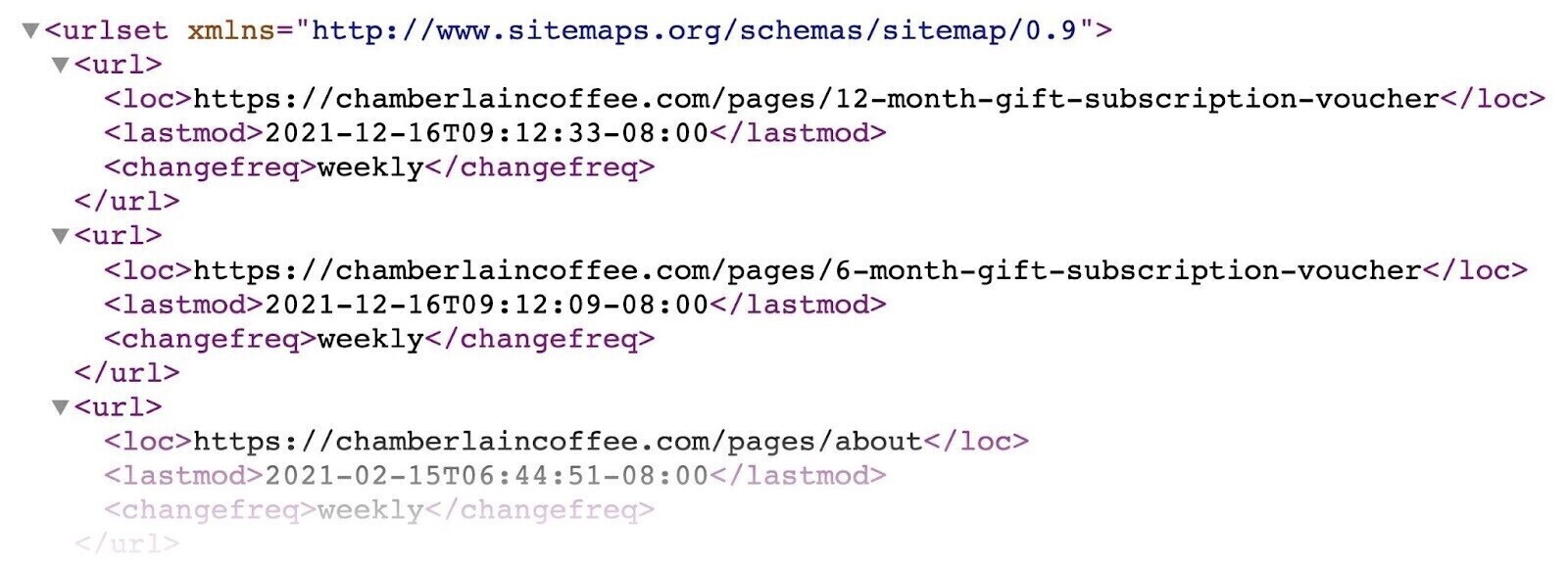

3. 让你的网站地图保持最新

拥有最新的XML网站地图是您可以将Google指向最重要页面的另一种方式。 并且在添加新页面时更新站点地图可以使它们更有可能被抓取(但这并不能保证)。

您的站点地图可能看起来像这样(它可以根据您生成它的方式而有所不同):

谷歌推荐仅包括您希望在站点地图中的搜索结果中显示的Url。 为了避免可能浪费爬网预算(请参阅下一个提示以获取更多信息)。

您还可以使用

进一步阅读: 如何向Google提交站点地图

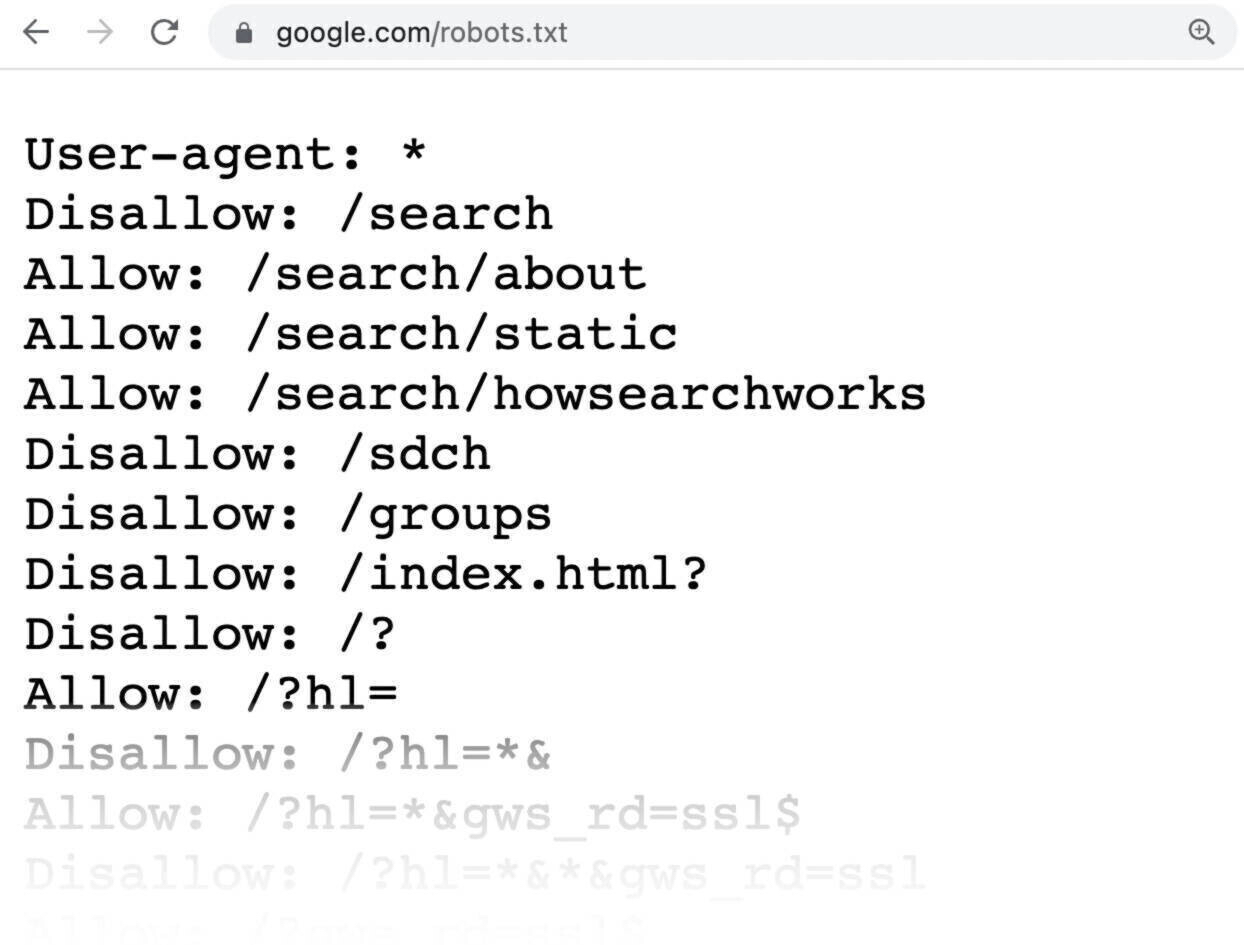

4. 阻止您不希望搜索引擎抓取的网址

使用你的robots.txt文件(一个告诉搜索引擎机器人哪些页面应该和不应该被抓取的文件),以最大限度地减少Google抓取您不希望它的页面的机会。 这可以帮助减少预算浪费。

为什么要阻止某些页面的抓取?

因为有些是不重要的或私人的。 而且你可能不希望搜索引擎抓取这些页面并浪费他们的资源。

这是一个机器人的例子。txt文件可能看起来像:

"Disallow:"之后的所有页面指定您不希望搜索引擎抓取的页面。

有关如何正确创建和使用这些文件的更多信息,请查看我们的机器人指南。txt脧脗脭脴.

5. 删除不必要的重定向

重定向将用户(和机器人)从一个URL带到另一个URL。 并且可以减慢页面加载时间并浪费抓取预算。

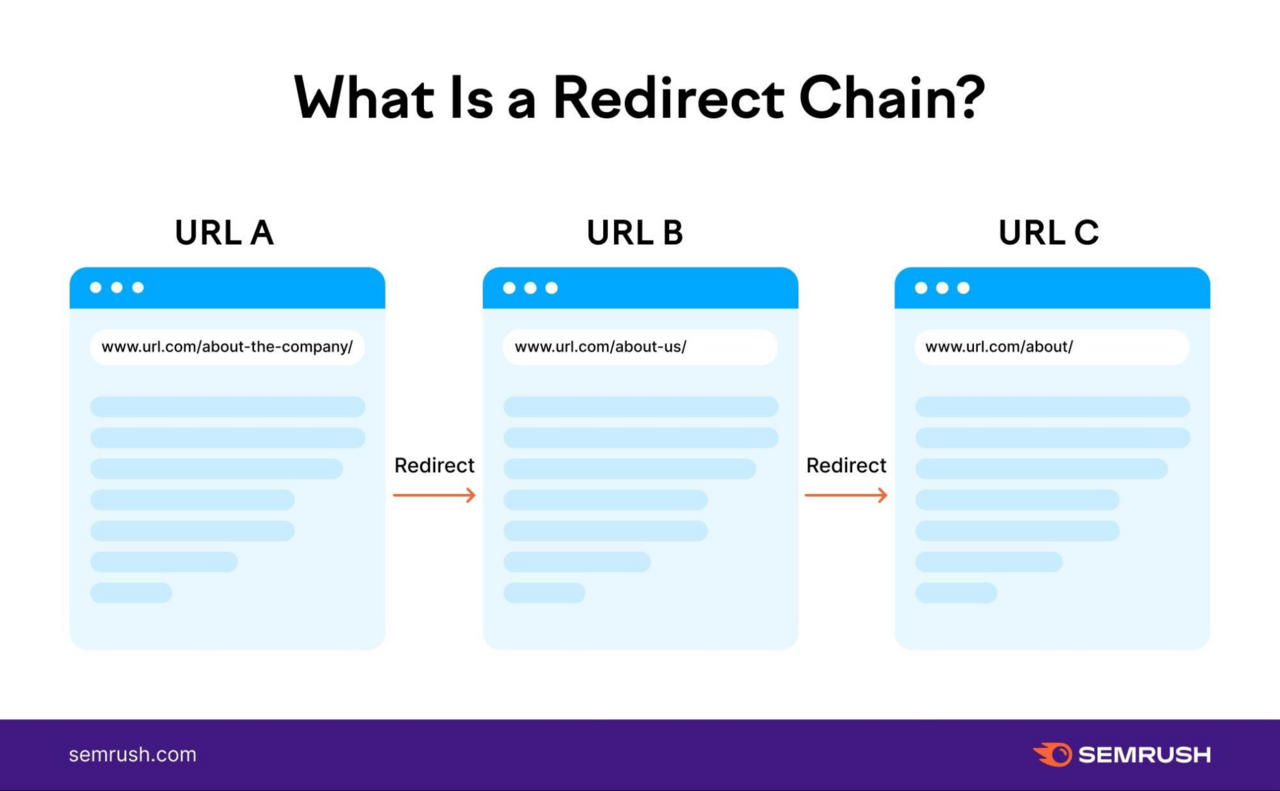

如果您有重定向链,这可能会特别成问题。 当您在原始URL和最终URL之间有多个重定向时,就会发生这些情况。

像这样:

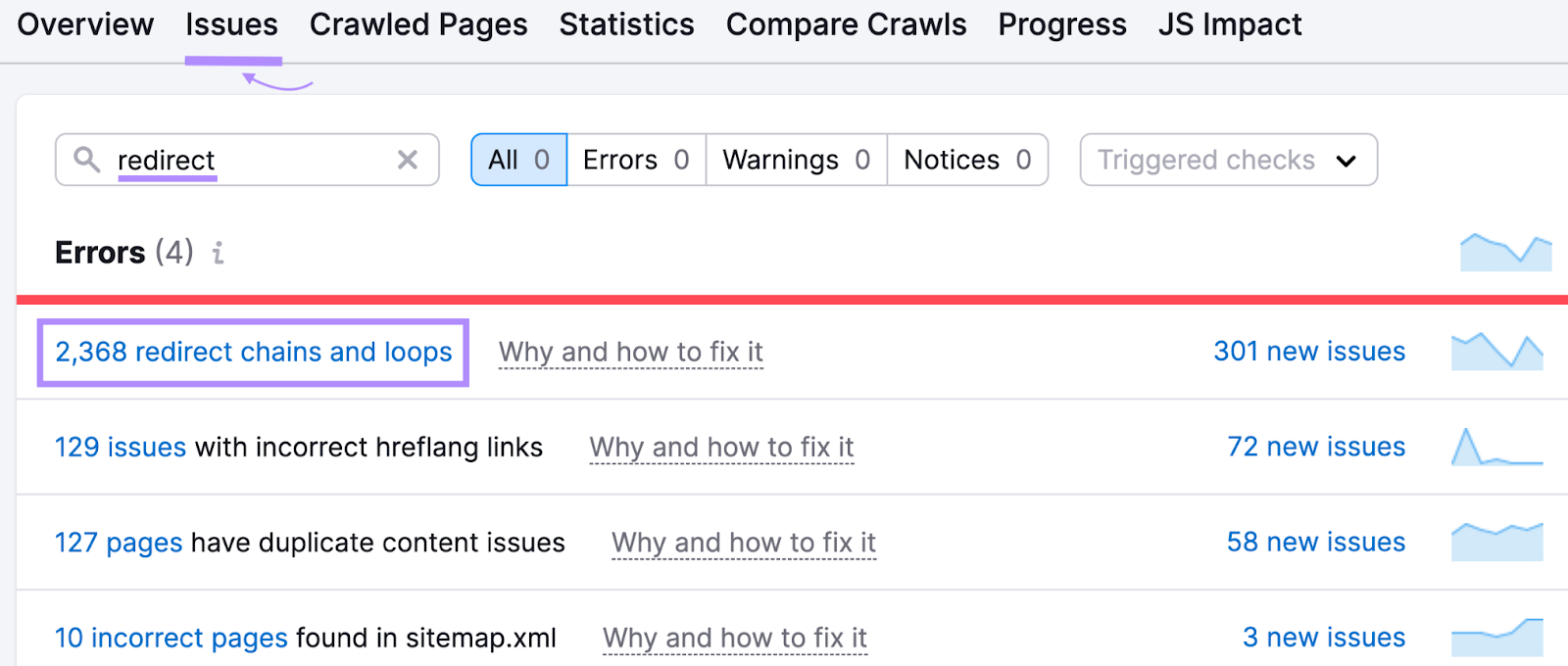

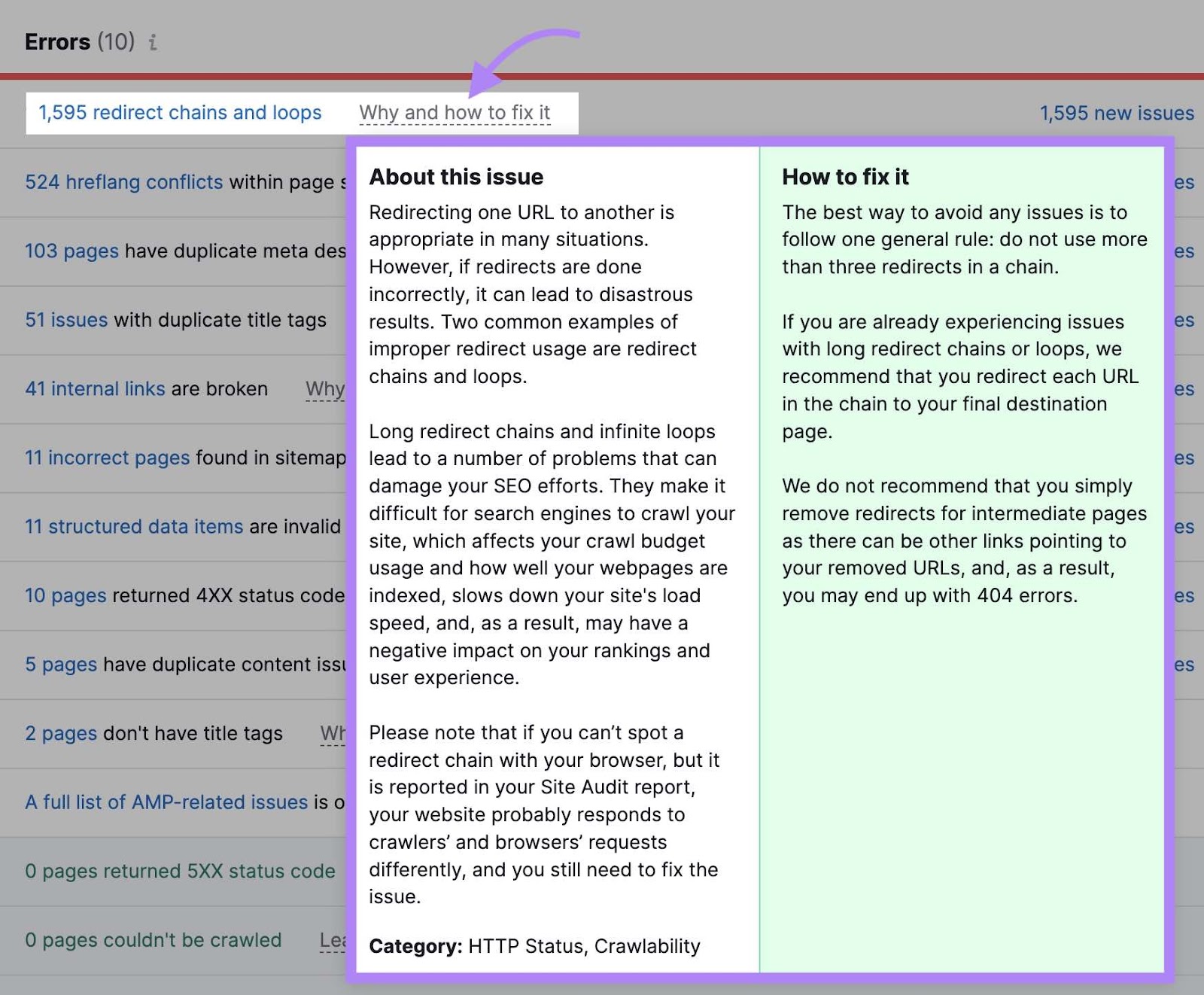

要了解有关在您的网站上设置的重定向的更多信息,请打开现场审核工具并导航到"问题"tab。

在搜索栏中输入"重定向"以查看与您的网站重定向相关的问题。

点击"为什么以及如何解决它"或"了解更多"以获得有关每个问题的更多信息。 并看到如何解决它的指导。

6. 修复损坏的链接

损坏的链接是那些不会导致活页的链接--它们通常返回一个404错误代码相反。

这不一定是坏事。 实际上,不存在的页面通常应该返回404状态代码。

但是有很多链接指向不存在的损坏页面会浪费抓取预算。 因为机器人可能仍然试图抓取它,即使页面上没有任何有价值的东西。 对于遵循这些链接的用户来说,这是令人沮丧的。

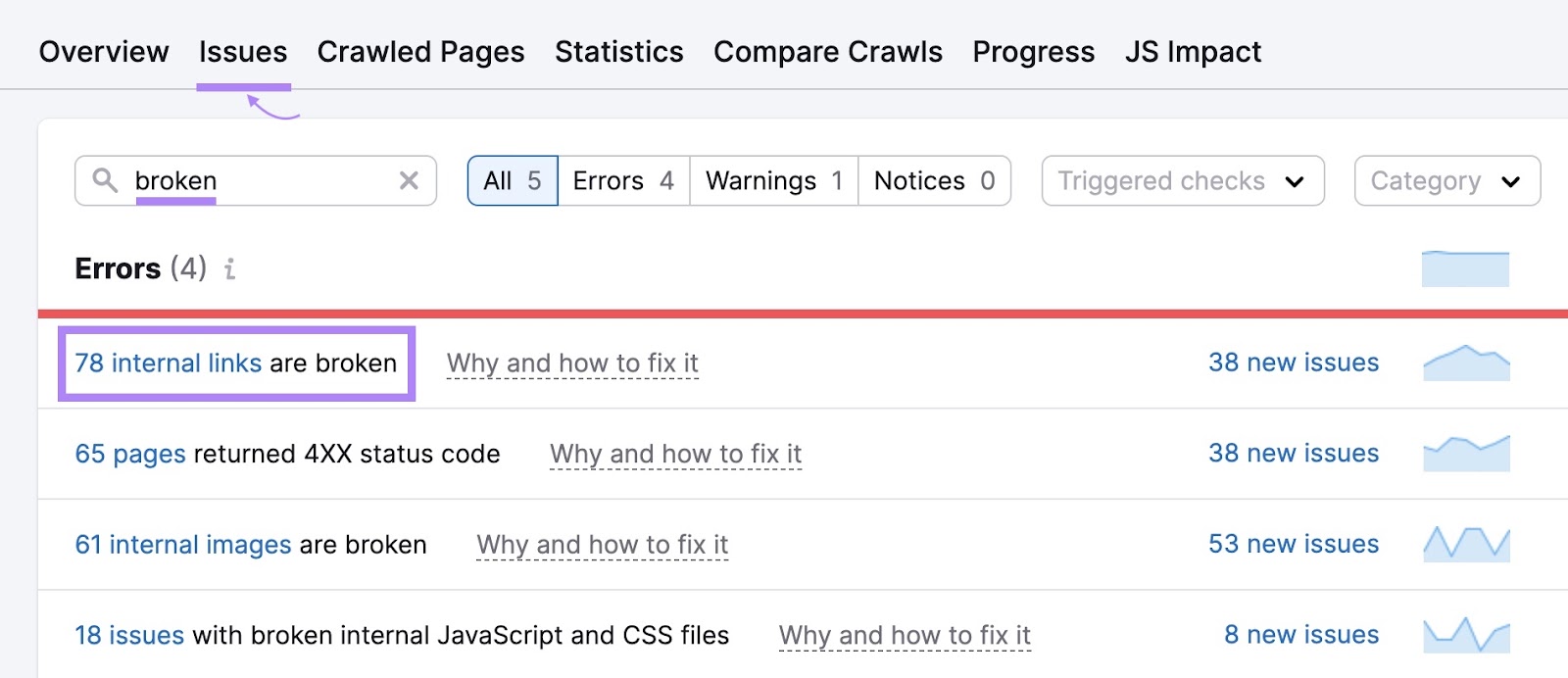

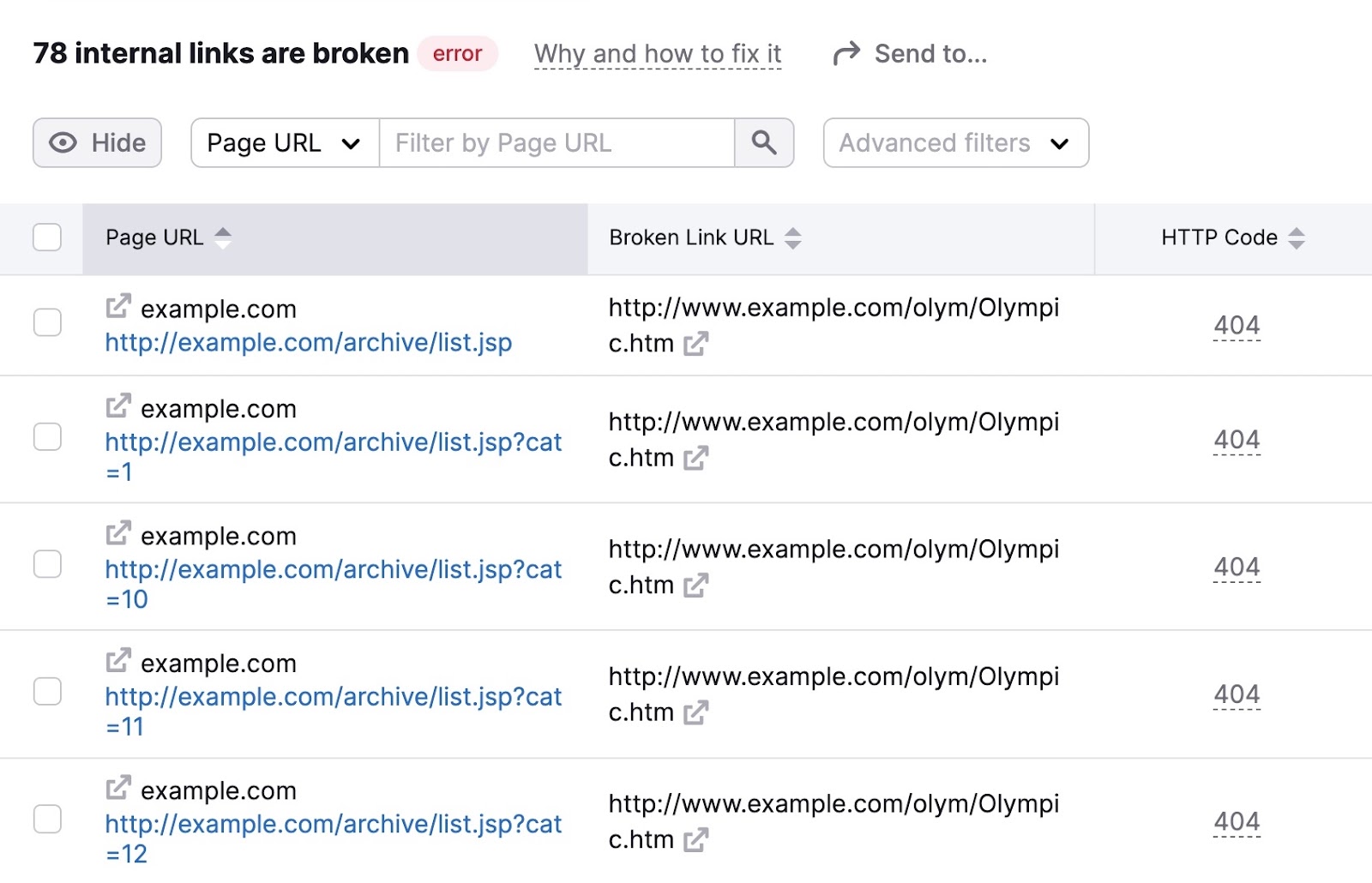

要识别网站上损坏的链接,请转到"问题"标签现场审核并在搜索栏中输入"broken"。

查找"#内部链接已断开"错误。 如果您看到它,请单击数字上的蓝色链接以查看更多详细信息。

然后,您将看到带有断开链接的页面列表。 以及每个页面上的特定链接。

浏览这些页面并修复损坏的链接,以提高您网站的可抓取性。

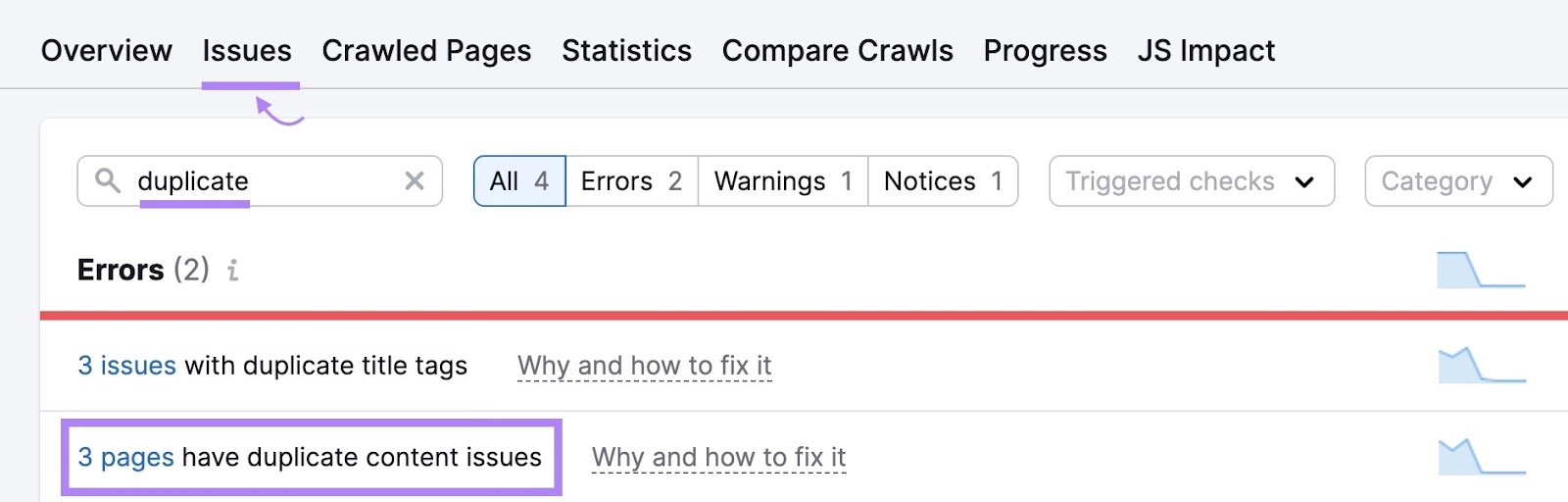

7. 消除重复内容

重复内容是当你在你的网站上有高度相似的网页。 这个问题可能会浪费抓取预算,因为机器人本质上是在抓取同一页面的多个版本。

重复的内容可以有几种形式。 如相同或几乎相同的页面(您通常希望避免这种情况)。 或因以下原因引起的页面变化URL参数(常见于电子商务网站)。

转到"问题"标签内现场审核以查看您的网站是否有任何重复的内容问题。

如果有,请考虑以下选项:

- 使用方法"rel=规范"标签在HTML代码中告诉谷歌你想在搜索结果中出现哪个页面

- 选择一个页面作为主页(确保添加任何额外的内容,包括在主页面中缺少的内容)。 然后,使用301重定向重定向重复项。

通过定期的网站审核,最大限度地提高爬网预算

定期监控和优化网站的技术方面可以帮助网络爬虫找到您的内容。

由于搜索引擎需要找到您的内容,以便在搜索结果中对其进行排名,因此这一点至关重要。

使用Semrush的现场审核工具来衡量你的网站的健康和发现错误之前,他们导致性能问题。

外贸B2B建站

外贸B2B建站  高端定制设计

高端定制设计  系统功能优势

系统功能优势

Google SEO优化

Google SEO优化  Google SEM广告

Google SEM广告  网站内容营销

网站内容营销  优化案例

优化案例  设计赏析

设计赏析  搜索引擎优化

搜索引擎优化  付费广告

付费广告  社媒运营

社媒运营  公司介绍

公司介绍  渠道共赢

渠道共赢  联系我们

联系我们